고난이도의 수학 문제를 해결하는 능력을 평가하는 새로운 수학 벤치마크가 등장했다. 첨단 인공지능(AI) 모델 'GPT-4o'와 '클로드'도 이 문제들 중 2%도 해결하지 못했다고 알려졌다.

벤처비트는 11일(현지시간) 에포크 AI 연구 그룹이 고차원적 추론과 창의력을 요구하는 수백개의 연구 수준 수학 문제를 담은 '프론티어매스(FrontierMath)'를 공개했다고 보도했다.

수학은 자연어 처리나 이미지 인식과 달리, 여러 단계를 거치는 정밀하고 논리적인 사고를 요구한다. 증명이나 해법의 각 단계가 이전 단계를 기반으로 하기 때문에, 하나의 실수만으로도 전체 해답이 틀릴 수 있다.

이런 특성 때문에 수학은 AI의 추론 능력을 시험하는 최적의 대상으로 꼽힌다. 단순히 답을 생성하는 것만으로는 부족하고, 문제의 구조를 이해하고 다단계 논리를 통해 정확한 해답에 도달해야 한다.

언어나 다른 분야에서는 평가가 주관적일 수 있지만, 수학은 명확하고 검증 가능한 기준을 제공하기 때문에 해결 여부가 명확히 드러난다.

특히 연구 수준의 수학 문제는 AI를 테스트하기에 매우 적합한 영역이다. 프론티어매스는 AI 시스템이 연구 수준의 수학적 추론 능력을 갖추었는지 평가하기 위해 기존의 수학 벤치마크보다 훨씬 더 어렵게 설계됐다.

기존의 GSM8K와 MATH와 같은 벤치마크는 AI 모델이 비슷한 유형의 문제로 학습했기 때문에 90% 이상의 점수를 기록하는 등 '데이터 오염' 문제가 지적됐다.

반면 프론티어매스 문제들은 완전히 새롭고 미발표된 문제들로, 단순한 암기나 패턴 인식으로 해결할 수 없다는 것이 특징이다. 이 문제들은 계산적 수 이론과 추상 대수기하학을 포함한 다양한 주제를 다루며, 인간 수학자들에게도 해결에는 수시간에서 며칠이 걸릴 수 있다.

특히 문제들은 ‘추측 불가(guessproof)’ 방식으로 설계, 수학적 작업을 거치지 않으면 해결이 거의 불가능하다. 해결책은 대개 큰 숫자나 복잡한 수학적 객체들로 이뤄져 있어, 적절한 추론 없이 맞출 확률은 1% 미만이다.

프론티어매스 벤치마크의 설계와 검토에는 '필즈상' 수상자인 세계 최고 수학자 테렌스 타오와 티모시 가워스, 리처드 보처즈, 국제 수학 올림피아드(IMO) 코치인 에반 첸 등이 참여했다. 이들은 문제들이 진정한 수학적 이해를 테스트하도록 특별히 설계되었음을 강조했다. 그 결과, 현재의 AI 시스템들이 이 문제들을 해결하기는 매우 어렵다는 평이다.

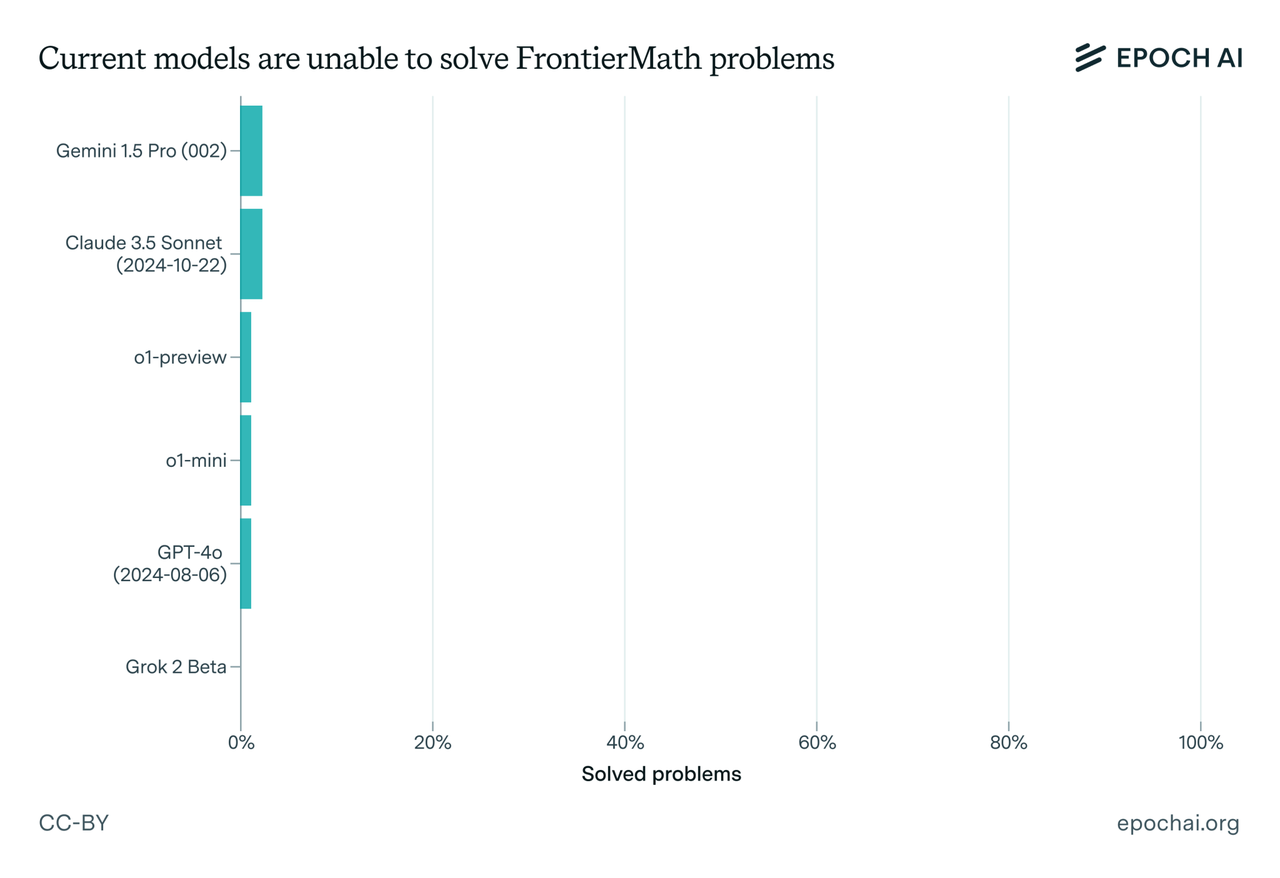

실제로 GPT-4o와 '제미나이 1.5 프로' '클로드 3.5 소네트' 등 6개의 주요 AI 시스템을 평가한 결과, 어느 시스템도 문제의 2% 이상을 해결하지 못한 것으로 전해졌다.

따라서 AI가 프론티어매스와 같은 문제들을 해결할 수 있다면, 이는 AI의 중요한 발전을 의미할 수 있다. 이는 단순히 인간의 행동을 모방하는 것을 넘어, 진정한 이해에 한걸음 더 가까워지게 되는 전환점을 나타낼 것이라는 설명이다.

매튜 바넷 AI 연구원은 "AI가 프론티어매스를 완전히 해결하면, 인간은 전혀 다른 종류의 지능을 가진 존재들과 함께 살게 될 것"이라고 말했다.

박찬 기자 cpark@aitimes.com