'o3'의 인공일반지능(AGI) 벤치마크로 유명해진 프랑수아 숄레의 아크 프라이즈 재단이 새로운 벤치마크를 공개했다. 이번 테스트는 높은 난이도로 인해, 오픈AI와 딥시크의 추론 모델조차 1%대의 점수에 그쳤다.

아크 프라이즈 재단은 25일(현지시간) 공식 블로그를 통해 새로운 벤치마크 ‘ARC-AGI-2’를 발표했다.

이번 벤치마크도 인간은 쉽게 해결하지만, AI는 어려워하는 과제로 구성됐다.

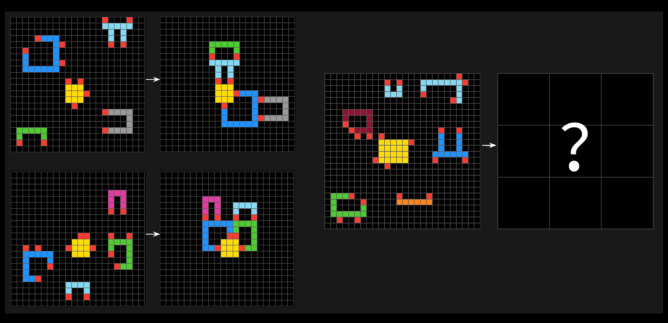

ARC-AGI-2 테스트는 AI가 다양한 색상의 사각형으로 구성된 패턴을 분석하고, 올바른 ‘정답’ 그리드를 생성해야 하는 퍼즐형 문제로 이뤄져 있다.

특히 AI가 기존에 학습하지 않은 새로운 문제에 적응할 수 있는지를 평가하는 것을 목표로 설계됐다.

숄레 창립자는 “ARC-AGI-2는 이전 버전보다 AI 모델의 실제 지능을 평가하는 데 더 적합하다”라며 “ARC-AGI-1과 달리, AI 모델이 막대한 컴퓨팅 자원을 활용해 정답을 찾아내는 ‘무차별 대입(brute force)’ 방식에 의존하지 못하도록 설계됐다”라고 설명했다.

그는 AI가 모든 경우의 수를 하나씩 대입하며 답을 찾는 무차별 대입이 통하는 것이 이전 버전의 가장 큰 문제라고 지적한 바 있다.

이 방식으로 주요 모델 성능을 측정한 '리더보드'에 따르면, 오픈AI의 'o1-프로'와 '딥시크-R1'과 같은 추론 AI 모델은 1%~1.3%의 점수를 기록했다.

'GPT-4.5'나 '클로드 3.7 소네트' '제미나이 2.0 플래시' 등 첨단 비추론 모델들은 약 1%의 점수를 얻었다.

심지어 ARC-AGI-1에서 인간과 흡사한 75.7%를 얻은 오픈AI의 o3도 이번에는 4%에 불과했다. 이는 현재 AI 모델의 한계를 명확히 보여준다는 평이다.

또 ARC-AGI-2 테스트의 인간 기준선을 설정하기 위해 400명 이상의 참가자를 대상으로 실험을 진행했다. 이들은 평균적으로 테스트 문제의 60%를 맞혔으며, 이는 AI 모델과는 엄청난 차이다.

아크 프라이즈 재단은 이제 AI 모델의 능력뿐만 아니라 효율성도 중요한 평가 기준으로 삼는다고 밝혔다.

즉, 인간은 과제당 평균 17달러의 비용으로 100% 성공률을 보인 반면, o3는 과제당 200달러로 4%만 달성했다는 것이다.

숄레 창립자는 “지능은 문제 해결 능력만이 아니라 그 능력을 효율적으로 획득하고 적용하는 것이 핵심”이라고 강조했다.

이에 앞서 지난 1월에는 '인류의 마지막 시험(Humanity's Last Exam)'이라는 벤치마크가 등장했다. 여기에서도 o1과 딥시크-R1은 정답률 10%에도 미치지 못했다.

또 전날에는 비영리 기구 METR이 '긴 작업을 완료하는 AI 능력 측정'이라는 벤치마크를 선보였다. 이는 단순 점수가 아니라, AI의 능력을 인간 능력을 기준으로 정량화하기 위한 방식이다.

이처럼 벤치마크 무용론에 대한 목소리가 높아지며 난이도를 높이거나 방식을 달리한 벤치마크가 속속 등장하고 있다.

실제로 벤치마크는 모델 개발만큼이나 중요한 분야로 여겨지고 있다. 대표적인 성공 사례 중 하나는 인간 선호도를 투표로 측정하는 'IM아레나'다.

박찬 기자 cpark@aitimes.com