얼마 전 영국 AI칩 스타트업 그래프코어(Graphcore)가 자사 2세대 지능처리장치(IPU, Intelligence Processing Unit)를 엔비디아 최신 A100 GPU와 비교한 벤치마크 점수를 발표했다.

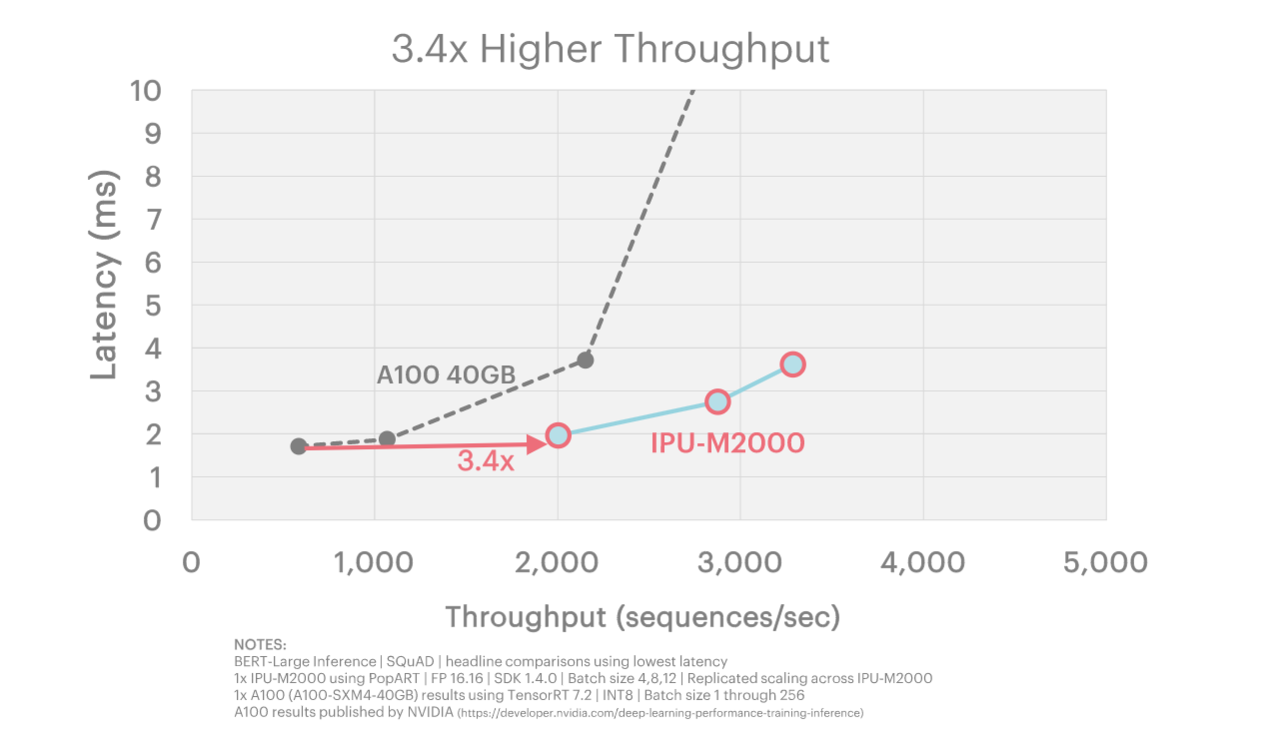

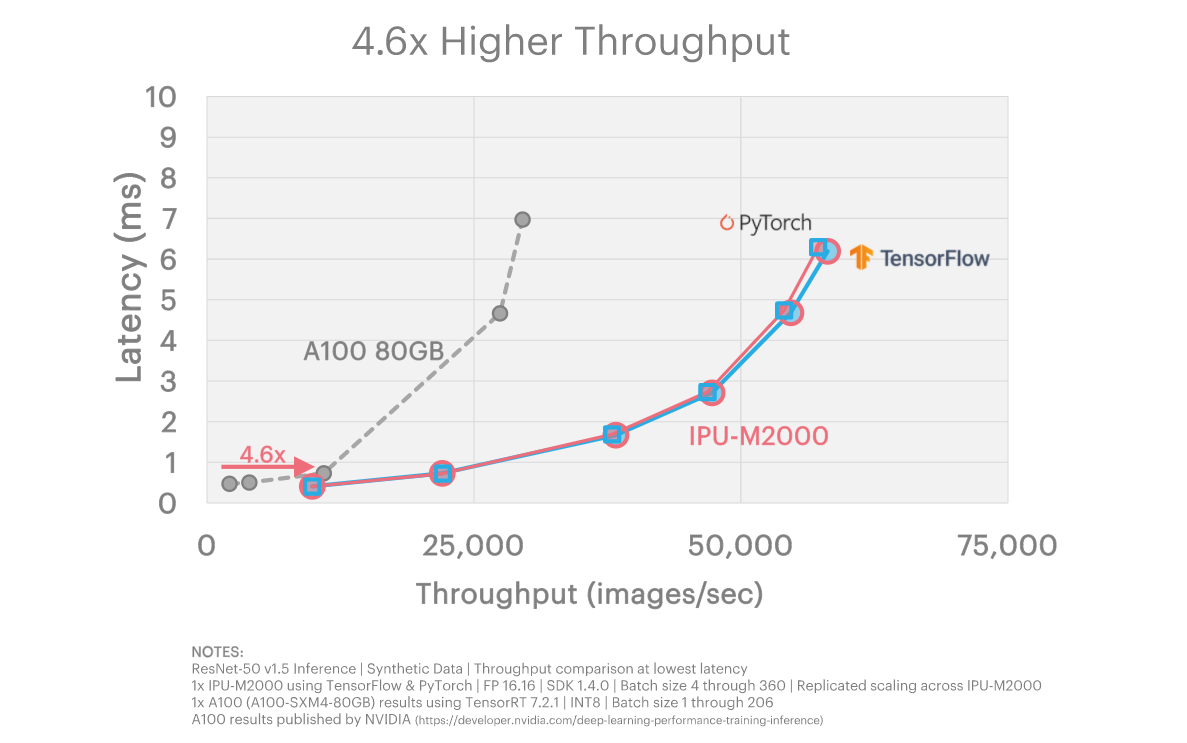

그래프코어는 자사의 2세대 IPU가 엔비디아 A100보다 월등히 높은 성능을 보였다고 주장했다. 그래프코어 벤치마크에 AI 훈련에서 3.7~18배, AI 추론에서 3.4~600배까지 차이가 났다.

◆"그래프코어 벤치마크, 공신력 부족해…1:1 기준으로 비교해야"

엔비디아와 일부 전문가들은 그래프코어의 점수가 공정하지 않다고 지적한다. MLPerf와 같은 공신력있는 데이터가 아닌 자체 기준으로 측정했기 때문에 공정성이나 실제 사용자 경험을 고려하지 못했다는 이유.

케빈 크루웰 티리아스 리서치 수석분석가는 "그래프코어의 벤치마크 점수는 오해의 소지가 있다"며 "많은 기업이 벤치마크와 성능 데이터를 자체 발표하지만, 이런 데이터는 항상 회의적으로 봐야 한다"고 말했다.

그는 "달러당 성능을 따지는 것은 AI 시스템 구매에 좋은 척도가 아니다"며 "왜냐하면 (AI 시스템) 소유 비용에는 여러 다양한 요소들을 고려해야 된다"고 덧붙였다. 단순한 칩의 가성비가 아닌 하나의 서버랙 공간에서 얼마만큼 성능을 낼 수 있느냐가 중요하기 때문이다.

EE타임스도 그래프코어의 벤치마크가 공정하지 않다고 지적했다.

EE타임스는 "그래프코어가 과거에 AI 칩 선두 업체인 엔비디아와 정면 대결하는 것을 주저하지 않았으나 이번 발표는 특히 대담해 보인다"며 "그래프코어의 발표에서 비교한 시스템의 규모는 일관성이 없어 보인다. 전체 성능 벤치마크뿐만 아니라 세부 사항에도 문제가 있다"고 20일(현지시간) 보도했다.

EE타임스에 따르면 대부분의 그래프코어 벤치마크는 IPU-MK2 칩이 4개 달린 시스템인 IPU-M2000을 단일 엔비디아 A100 GPU와 비교했으며, Mk2 칩 64개가 장착된 IPU-Pod64를 A100이 8개 탑재된 DGX-A100 시스템 한두개와 비교했다.

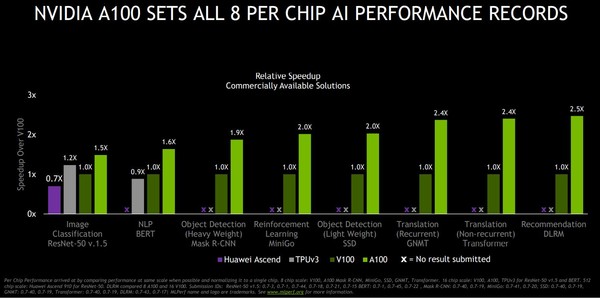

엔비디아 가속 컴퓨팅 제품 관리 책임자 파레시 카리야(Paresh Kharya)는 EE타임스에 "그래프코어는 모델, 알고리즘, 사용되는 시스템 구성 측면에서, 모델에 대해 교육을 받은 정확도와 같은 주요 세부 사항이 부족했다"며 "일관적인 방법론을 사용해 비교했을 때 엔비디아 A100은 모든 AI 모델을 실행할 수 있는 훨씬 더 높은 성능, 다재다능함, 성숙한 소프트웨어 스택을 제공하므로 개발자들은 처음부터 생산성을 높일 수 있다"고 말했다.

MLPerf와 같은 독립적인 AI 벤치마크에서 엔비디아 A100은 높은 성능을 보였다는 것이다. 최근에는 11개 기업이 엔비디아 소프트웨어 스택을 사용해 엔비디아 기반 시스템 성능 점수를 제출하기도 했다.

이런 결과가 엔비디아 GPU 성능과 소프트웨어 스택의 완성도를 검증하며, 대규모 개발자 커뮤니티의 의견을 반영한다는 것이다.

카리야는 "벤치마킹은 미묘한 차이가 있으며 성능과 실제 고객 경험에 영향을 미칠 수 있는 변수가 많다"며 "이것이 바로 MLPerf가 만들어진 이유다. 알고리즘과 측정 기준을 표준화해 주변의 검토를 거쳐 고객이 실행하는 것을 대표하도록 함으로써 비교가 가능하도록 하기 위해서"라고 설명했다.

◆그래프코어 "가성비 기준으로 비교한 것"…엔비디아 GPU 비싼 가격 지적

그래프코어는 엔비디아와의 벤치마크가 가격과 성능면에서 비교하기 때문에 다양한 기준으로 비교했다고 반박했다.

엔비디아 칩의 비싼 가격 문제는 소비자들에게 오랜 불만이었다, 하지만 AI 가속기 시장이 엔비디아에 독점된 생태계에서 소비자들은 다른 선택권이 없었다.

그래프코어는 이런 소비자들에게 새로운 대안을 제시했다는 것이다. 그래프코어의 칩을 사용하면 엔비디아보다 더 저렴하게 같은 성능을 구사할수 있기 때문이다.

그래프코어 제품마케팅 담당 크리스 툰슬리 이사는 EE타임스에 "제품을 비교할 때 표준화할 수 있는 변수는 많지만, 고객이 관심을 갖는 칩은 많지 않다"며 "우리 고객들은 달러당 성능을 비교한다"고 강조했다.

툰슬리는 모든 제품이 1:1로 비교되지는 않는다고 주장했다. 그는 "그래프코어 제품은 4개의 MK2 IPU로 구성된 IPU-M2000과 64개의 IPU가 포함된 4개의 IPU-Pod64로 이뤄졌다"며 GPU를 2개, 8개씩 묶어서 제공하는 A100 GPU 제품군과 다르다고 설명했다.

"가격과 전력 소비량을 기준으로 가장 근접한 비교는 IPU-M2000과 A100 DGX 1개"라며 "고객이 자체 분석과 비교를 할 수 있도록 성능 결과에 대한 모든 데이터를 웹 사이트의 표에 데이터로 제공했다"고 그는 덧붙였다.

EE타임스에 따르면 그래프코어는 IPU-M2000의 권장 소매가가 3만 2450달러라고 말했다. 하지만 여기에는 시스템 실행에 필요한 CPU 서버가 포함되지 않았다.

엔비디아의 8개 GPU의 DGX-A100은 19만 9000달러부터 시작한다. 또 CPU를 포함한 4배 A100 GPU(슈퍼마이크로 A+ 서버 2124GQ-NART)를 갖춘 A100 가속 서버는 5만 7000달러부터 시작한다.

보통 성능 벤치마크에는 가격은 비교 대상이 아니다. 제품을 1:1로 비교하는 것이다.

EE타임스는 "가격은 제조사가 가격 전략에 따라 정한다"고 지적했다.

이밖에도 전력 소비량, 냉각 요구사항, 물리적 크기 등 실제 시스템에 필요한 다양한 고려 사항이 있다. 투자 수익률, 사용 편의성, 솔루션 출시 시간, 인프라 유연성 등 같은 요인은 고객마다 가중치가 다르다.

그래프코어가 발표한 일부 비교에서는 엔비디아가 발표한 A100용 벤치마크 수치를 사용하기도 하지만, 일부는 클라우드에서 엔비디아 하드웨어를 사용해 측정한 결과를 사용하기도 했다.

실험 결과가 제품의 현실적인 고객 경험을 나타낼 수 있다고 주장할 수 있지만, 이는 하드웨어 제조업체 자체의 최적화된 벤치마크 점수와 다를 수 있다.

◆"벤치마크에 성능 외 다른 요소 들어가면 안 돼"

EE타임스는 "벤치마킹은 복잡하고 미묘한 작업이며, AI 훈련과 추론 워크로드의 경우 특히 더 심하다"며 "이런 이유로 개방형 엔지니어링 컨소시엄인 ML커먼스에 의해 관리되는 MLPerf AI 훈련과 추론 벤치마크가 더욱 중요해지고 있다"고 강조했다.

데이비드 칸터 ML커먼스 전무 이사는 EE타임스에 "머신러닝 시스템은 엄청나게 복잡하고 전처리, 수치, 정확성, 지연 시간과 같은 요인을 포함해 전체 소프트웨어와 하드웨어 스택에 걸쳐 신중한 최적화를 요구한다"며 "MLPerf는 일반적인 기계 학습 모델 또는 더 새로운 구현을 사용하여 비교를 위한 올바른 접근법 뿐만 아니라 명확한 작업과 성능 측정 기준을 확립한다"고 전했다.

최근 그래프코어는 ML커먼스에 합류할 것이며 2021년에는 MLPerf에 벤치마크 점수를 제출할 계획이라고 발표했다. MLPerf 추론 벤치마크 점수의 다음 라운드는 내년 1분기 후반에 발표되며, 다음 라운드 훈련 점수는 2분기에 발표된다.

툰슬리는 "그래프코어는 이제 MLPerf에 점수를 제출하는 데 필요한 상당한 시간을 할애할 수 있게 됐다"며 "지금까지 우리는 고객 모델에 집중해 왔다. 벤치마킹 기능을 개발하기 위해 특정 벤치마킹 팀을 구성하고 있으며, 그 중 가장 먼저 MLPerf가 선정됐다"고 말했다.

신생 스타트업은 대기업인 엔비디아처럼 MLPerf에 한정된 자원을 쉽게 투자하기는 어려울 수밖에 없었다.

그래프코어가 본격적으로 ML커먼스에 합류한 다음 MLPerf 라운드에서는 양사 AI 가속기의 비교가 보다 공정하게 이뤄질 것으로 기대된다.

AI타임스 양대규 기자 yangdae@aitimes.com

- 사이먼 놀스 그래프코어 CTO, "HBM, AI 훈련에 적합하지 않아"

- [AI칩러닝] AI의 핵심, GPU… 딥러닝의 유행을 불러오다 ①

- 하일로·그래프코어·그로크…보다 '성숙한' AI칩 스타트업

- 정부, 사람 중심의 'AI 윤리 원칙' 최종 발표...3대 원칙과 10대 요건으로 구성

- 심층신경망(DNN)이 예측한 최대 노화 요인은 결혼 스트레스?

- 알파IC, "미지의 데이터를 분류하는 엣지 AI칩 개발"

- [GTC2021] 젠슨 황 엔비디아 CEO 품 안엔 'AI·자율주행' 있었다

- NHN, AI 클라우드 경쟁력 확보 위해 그래프코어와 맞손..."국내 AI 생태계 강화할 것"

- 그래프코어, AI 연산 시스템 IPU-POD 모델군 확대...KT 초대규모 AI 컴퓨팅 환경 지원