미국의 AI 스타트업 ‘삼바노바 시스템즈(SambaNova Systems)’가 ‘데이터스케일 SN30(DataScale SN30)’이라는 새로운 하드웨어-소프트웨어 통합 AI 시스템을 출시했다고 HPC와이어가 14일(현지시간) 보도했다.

데이터스케일 SN30은 이전 SN10 시스템의 성능을 대폭 개선하고 대규모 AI 모델을 지원하도록 업그레이드한 차세대 시스템이다.

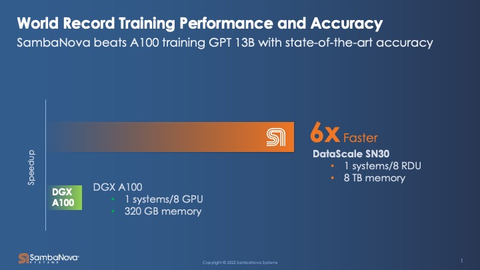

A100 텐서 GPU를 기반으로 구축된 엔비디아 DGX A100 시스템과 경쟁하는 삼바노바는 새로운 데이터스케일 SN30 시스템이 대규모 AI 모델을 지원하며 GPT 모델을 빠른 속도로 훈련할 수 있다고 주장했다. 데이터스케일 SN30은 DGX A100 시스템에 비해 특정 AI 워크로드에서 6배 속도 향상이 가능하고, 12.8배 더 많은 메모리 용량을 제공한다.

또 하드웨어와 소프트웨어를 통합해 더 빠른 컴퓨팅 능력을 제공하는 것이 SN30 디자인의 핵심이다. 데이터스케일 SN30 시스템은 소프트웨어 정의 접근 방식으로 데이터 유형에 따라 CPU에서 GPU로 전환할 수 있다. 이것이 SN30 아키텍처가 다른 AI 아키텍처와 차별화되는 부분이다. 사용자는 워크로드의 요구 사항을 충족하도록 프로세서를 재구성해 신경망에 고효율 성능을 제공할 수 있다.

삼바노바는 SN30 기반 재구성 가능한 데이터 흐름 장치를 위한 새로운 프로세서 ‘카디널(Cardinal) SN30 RDU’도 공개했다 카디널 SN30 RDU는 TSMC의 7nm 공정에서 제조되고 860억개의 트랜지스터를 포함하며 FP16 정밀도에서 688테라플롭이 가능하다. 마샬 조이 삼바노바 제품 수석 부사장은 "칩을 별도로 판매하지 않지만 고객에게 사전 훈련된 딥 러닝 모델을 제공하는 데이터 시스템 및 데이터 플로우 서비스(Dataflow-as-a-Service)의 핵심 구성 요소"라고 설명했다.

카디널 SN30 RDU는 큰 매개변수를 필요로 하는 GPT와 같은 대규모 모델, 최고 해상도를 요구하는 컴퓨터 비전 모델, 임베딩 테이블이 필요한 추천 엔진을 실행하기 위해 엄청난 양의 메모리를 제공하는 시스템 아키텍처 등에 적용된다.

재구성 가능한 데이터 플로우 아키텍처는 삼바플로우(SambaFlow)라는 오픈 소스 소프트웨어 스택을 실행해 각 머신 러닝 모델이 시스템에서 최적으로 실행되도록 한다. 동적 랜덤 액세스 메모리와 인터페이스할 필요성을 최소화해 수행함으로써 AI의 주요 병목 현상, 즉 프로세서와 메모리 간의 상호 연결을 제거한다.

가트너의 분석가인 카이렉 디케이트는 "SN30을 통해 삼바노바가 프로세서 속도를 두 배로 늘리고 메모리 용량을 개선함으로써 시스템의 모델 성능을 개선했다"고 평가했다.

엔비디아, 인텔 및 AMD와 같은 다른 AI 하드웨어 공급업체와 마찬가지로 삼바노바는 은행, 제약 및 에너지 산업 및 과학 연구의 응용 프로그램을 위해 전문화된 인프라와 복잡한 모델의 생산 가속화가 필요한 기업에 적합한 모델을 제공한다.

삼바노바 측은 "미국 에너지부의 아르곤 국립 연구소가 유전자 생성을 위한 GPT 사용, 중성미자 물리학을 위한 3D 컨볼루션 네트워크, 단일 및 쌍 약물에 대한 종양 반응 예측을 포함한 애플리케이션에서 SN30 플랫폼을 테스트할 것으로 예상한다"고 덧붙였다.

박찬 위원 cpark@aitimes.com

[관련기사]엔비디아, GPU 벤치마크 테스트서 기술력 입증

[관련기사]핫칩스34에서 맞붙은 미래 반도체 전쟁