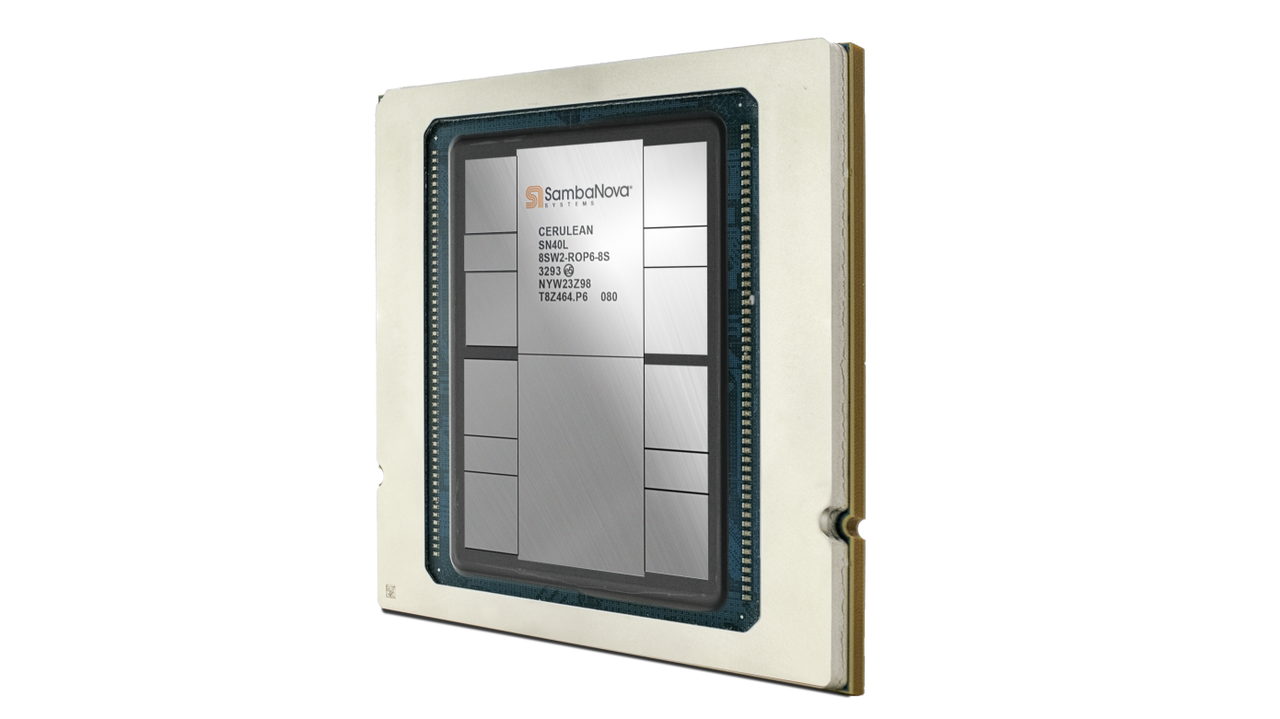

테크크런치는 19일(현지시간) 인공지능(AI) 칩 스타트업 삼바노바가 5조개의 매개변수를 갖춘 AI 모델을 저비용으로 구동할 수 있도록 설계된 새로운 프로세서 ‘SN40L’을 출시했다고 보도했다.

이에 따르면 8개의 SN40L 칩이 탑재된 서버는 5조개의 매개변수를 가진 대형언어모델(LLM)을 구동할 수 있다. 삼바노바는 이 정도 규모의 LLM을 실행하려면 엔비디아의 최첨단 GPU인 'H100' 192개가 필요하다고 설명했다. 특히 3만달러(약 4000만원) 이상에 판매되는 GPU수를 줄이면 비용을 크게 줄일 수 있다고 강조했다.

SN40L은 삼바노바 고유의 재구성 가능한 데이터 흐름 아키텍처를 통해, AI 모델을 분석하고 내부 구조를 자동으로 매핑해 모델의 성능을 최대화하는 방식이다.

신경망은 상호 연결된 수많은 소프트웨어 모듈인 '계층'으로 구성되며, 계층 간에는 데이터를 교환한다. 데이터가 빠르게 이동할수록 신경망이 더 빠르게 실행되는 원리다.

예를 들어 두개의 계층이 프로세서의 반대쪽 끝에 배치될 경우, 정보가 두 계층 사이를 이동하는 데 오랜 시간이 걸린다. 반면 인접한 두 계층은 순간적으로 통신할 수 있다.

SN40L은 AI 모델을 분석해 데이터를 교환할 계층을 결정하고, 정보 흐름 속도를 높이기 위해 계층을 나란히 배치할 수 있다. 또 5나노 제조 공정을 사용, 7나노 공정에서 제조된 삼바노바의 이전 세대 칩에 비해 속도를 크게 향상했다.

성능 향상의 또 다른 요인은 늘어난 코어 수다. 이 칩에는 2개의 칩렛 또는 반도체 모듈에 분산된 140개의 AI 최적화 코어가 있다. 코어는 1.5테라바이트(TB) 이상의 데이터를 함께 저장할 수 있는 세개의 개별 메모리 셋으로 지원한다.

첫번째 메모리 풀은 프로세서에 내장된 520MB 상당의 SRAM으로 구성된다. 520MB 미만의 공간을 차지하는 AI 모델은 SRAM에 완전히 저장할 수 있다. 이를 통해 오프칩 메모리를 사용할 필요가 없어 처리 속도가 빨라진다.

SN40L의 SRAM과 같은 온칩 메모리는 컴퓨팅 코어에 더 가깝기 때문에 오프칩 메모리보다 빠르다. 메모리와 컴퓨팅 회로 사이의 거리가 짧을수록 데이터가 그사이를 이동하는 데 걸리는 시간이 줄어들어, 결과적으로 성능이 향상된다.

삼바노바에 따르면 SRAM은 SN40L에 내장된 것이 아니라, SN40L에 부착된 1.5TB DDR5 메모리 풀과 쌍을 이룬다. DDR5 메모리 풀은 매개변수 수가 많은 대규모 AI 모델을 지원하는 데 유용하다.

마지막으로 성능 향상을 위해 DDR5보다 빠르고 비싼 DRAM 유형인 64GB의 HBM3를 탑재했다는 설명이다.

호드리구 리앙 삼바노바 CEO는 "이제 우리는 가장 스마트한 컴퓨팅 코어로 더 많은 메모리를 처리할 수 있는 기능을 하나의 칩으로 제공할 수 있다"며 "기업은 GPT-4 이상의 매개변수를 가진 자체 LLM을 활용할 수 있다"고 말했다.

삼바노바는 사전 패키징한 AI 모델을 체험할 수 있도록 클라우드 플랫폼 ‘삼바노바 수트(SambaNova Suite)’에서 칩을 먼저 출시했다. 여기에는 메타의 ‘라마 2’를 포함해 몇가지 모델이 포함됐다.

아울러 11월에는 온프레미스 ‘데이터스케일(DataScale)’ 어플라이언스와 함께 칩을 사용할 수 있도록 할 예정이다. 각 어플라이언스는 여러개의 SN40L 칩을 네트워킹 장비, 데이터 저장 장치 및 기타 지원 구성 요소와 결합한 형태다. 까다로운 AI 애플리케이션을 갖춘 기업은 여러 데이터스케일 시스템으로 클러스터를 구축할 수 있다.

박찬 기자 cpark@aitimes.com