로봇에 눈을 달아 줄 인공 시각 피질이 개발됐다.

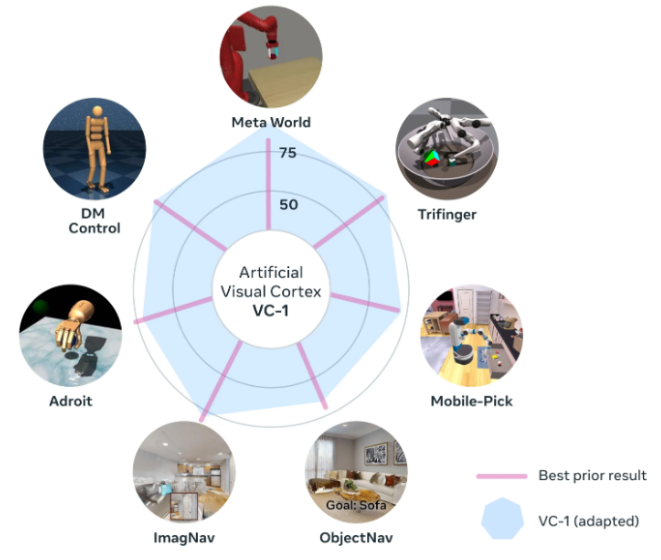

메타는 지난달 31일(현지시간) 블로그를 통해 일상적인 작업을 수행하는 수천 개의 비디오로 구성된 ‘에고4D(Ego4D)’ 데이터 세트로 훈련한 인공 시각 피질인 ‘VC-1’을 개발했다고 발표했다.

시각 피질은 생명체가 시각 정보를 동작으로 전환할 수 있게 해주는 뇌의 영역이다.

메타는 요리와 청소 등 일상적인 행동을 1인칭 시점으로 보여주는 수천 시간의 비디오로 구성한 에고4D 데이터 세트로 VC-1을 훈련, 사람의 개입 없이 카메라 입력을 인식해 작업을 수행할 수 있도록 했다.

이같은 인공 시각 피질 개발은 인간의 개입 없이 현실 세계와 상호 작용할 수 있는 범용 AI 에이전트를 생성으로 이어길 것으로 기대된다.

하지만 로봇이 실제로 홀로 작동하려면 물체를 조작할 수 있어야 한다. 이를 위해서는 시각 및 청각 입력을 토대로 물체로 이동해 들어올린 후 다른 위치로 이동해 내려놓는 일련의 과정을 포함한다.

메타는 이 문제를 해결하기 위해 조지아공대 전문가들과 협력해 ‘적응형 기술 조정(ASC: Adaptive Skill Coordination)’이라는 새로운 방법을 개발했다. ASC는 시뮬레이션 환경에서 로봇을 훈련한 다음 해당 기술을 실제 세계 로봇에 배포하는 방법이다.

이 방법의 효과는 보스톤 다이나믹스와 협력해 증명했다. ASC를 보스톤 다이나믹스의 로봇 ‘스폿(Spot)’ 로봇과 통합, ‘해비타트(Habitat)’ 시뮬레이터로 ASC 기술을 테스트했다. HM3D 및 ‘리플리카CAD(ReplicaCAD)’ 데이터셋으로 구성한 실내 3D 스캔을 사용했다.

스폿 로봇은 낮선 집 안에서 이동하고 잘못된 위치에 있는 물건을 집어 적절한 위치에 내려놓을 수 있도록 훈련했다. 이렇게 훈련한 스폿 로봇은 같은 작업을 자동으로 수행할 수 있었다.

메타는 VC-1 모델을 오픈소스로 공개하고, 모델과 데이터셋 크기 등을 확장하는 방법도 자세하게 공유할 예정이다.

박찬 위원 cpark@aitimes.com