구글의 '제미나이'가 실시간으로 여러 시각적 스트림을 동시에 처리할 수 있는 기술을 갖춘 첫 모델이라는 주장이 나왔다. 즉, 이미지 처리와 영상 처리가 동시에 가능한 첫 모델이라는 설명이다.

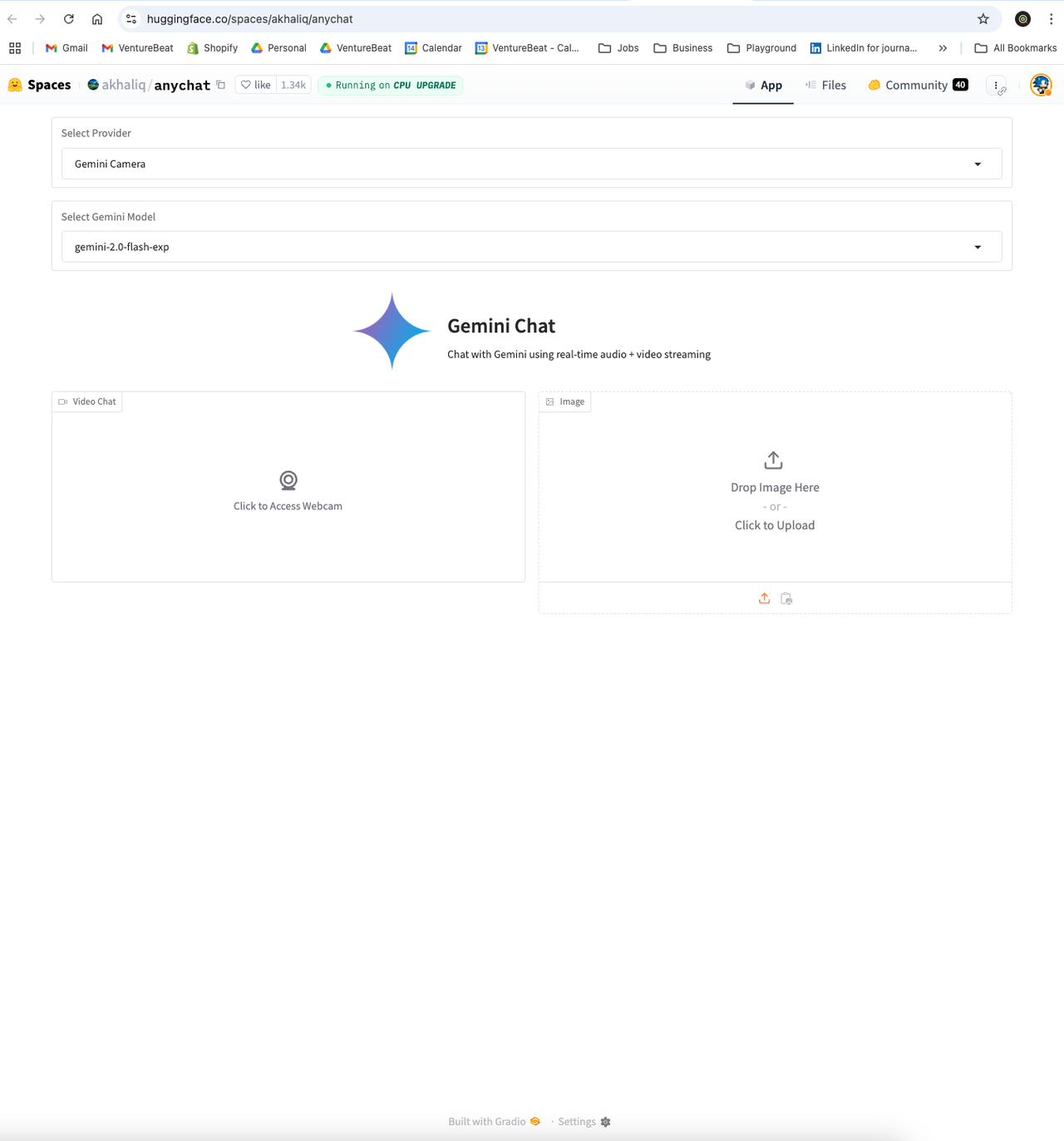

벤처비트는 14일(현지시간) 실험적인 애플리케이션 ‘애니챗(AnyChat)’을 통해 제미나이가 라이브 비디오 피드와 정적 이미지를 동시에 분석하는 멀티 스트림 처리 기능을 선보였다고 소개했다.

기존 인공지능(AI) 모델은 동영상과 이미지를 따로 처리할 수 있었으나, 두가지를 동시에 처리하는 것은 불가능했다. 하지만, 제미나이를 도입한 애니챗은 처음으로 이를 넘어서, 두가지를 동시에 처리했다는 주장이다.

애니챗을 만든 아흐센 칼리크 그라디오 머신러닝 리더는 "이 기능은 구글이 제공하는 제미나이 유료 서비스에서도 확인할 수는 없다"라며, 이 기능이 감춰져 있다고 설명했다.

챗GPT를 포함한 많은 AI 모델은 단일 스트림 처리만 가능하다. 예를 들어, '챗GPT'는 이미지 업로드 시 동영상 업로드는 비활성화한다. 동영상 분석만으로도 리소스를 많이 소모하는데, 이미지 분석까지 결합하면 더 큰 부담을 주기 때문이다.

제미나이의 멀티 스트림 기능은 고도화된 신경망 아키텍처 덕분에 가능하며, 애니챗은 이 인프라를 활용해 여러 시각적 입력을 성능 저하 없이 처리한다는 설명이다. 이 기능은 이미 제미나이의 API에 존재하지만, 구글의 공식 AI 플랫폼에서는 제공되지 않는다.

멀티 스트림 처리를 이용하면, 카메라로 수학책을 동영상 촬영하는 도중 각 페이지에 포함된 문제까지 풀 수 있게 된다. 예술가들은 작품을 만드는 도중에 참고 이미지를 공유, 구성과 기법에 대한 실시간 피드백을 받을 수 있다.

이처럼 애니챗은 제미나이 공식 버전에서 제한된 기능을 우회하는 방법을 사용했다. 이는 제미나이 API에서 특별한 권한을 받아 가능해졌으며, 이를 통해 애니챗은 구글의 다른 플랫폼에서는 제공되지 않는 기능을 사용할 수 있게 됐다는 설명이다.

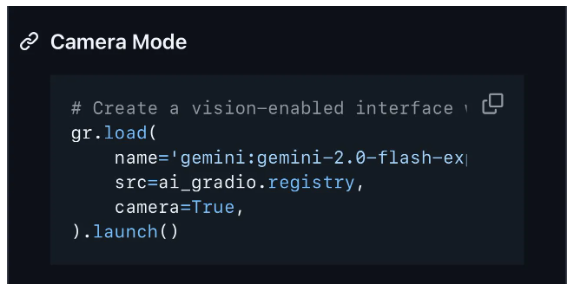

확장 권한을 활용한 애니챗은 제미나이의 '어텐션(attention)' 메커니즘을 최적화해 여러 시각적 입력을 동시에 추적하고 분석할 수 있다. 또 그라디오의 스니펫을 통해 개발자들이 제미나이 기반의 이미지 업로드 기능을 지원하는 비디오 채팅 플랫폼을 만들 수 있다.

칼리크 리더는 “구글 AI 스튜디오의 실시간 비디오 기능은 스트리밍 중 이미지 업로드를 처리할 수 없다”라며 “현재 다른 어떤 플랫폼도 이런 종류의 동시 처리를 구현한 곳은 없다”고 강조했다.

한편, 제미나이가 이 기능을 정식 출시하지 않은 것에는 의문이 생긴다. 또 구글이 이를 공식 플랫폼에 통합할지도 확실하지 않다.

하지만 제미나이의 멀티 스트림 처리가 가능하다는 사실이 입증됨에 따라, AI 애플리케이션도 기존 멀티모달의 수준을 넘는 단계로 접어들었다는 평이다.

박찬 기자 cpark@aitimes.com