카카오(대표 정신아)는 ▲이미지 정보 이해 및 지시 이행 능력을 갖춘 소형 멀티모달 언어모델 ‘카나나-1.5-v-3b’와 ▲전문가 혼합(MoE) 언어모델 ‘카나나-1.5-15.7b-a3b’를 오픈 소스로 공개했다고 24일 밝혔다.

카나나-1.5-v-3b는 지난 5월 공개한 '카나나-1.5-3B-인스트럭트'를 기반으로 개발됐다. 인간 선호 반영 학습(HPAT)과 지식 증류를 통해, 카나나-1.5-v-3b의 성능을 극대화했다고 설명했다.

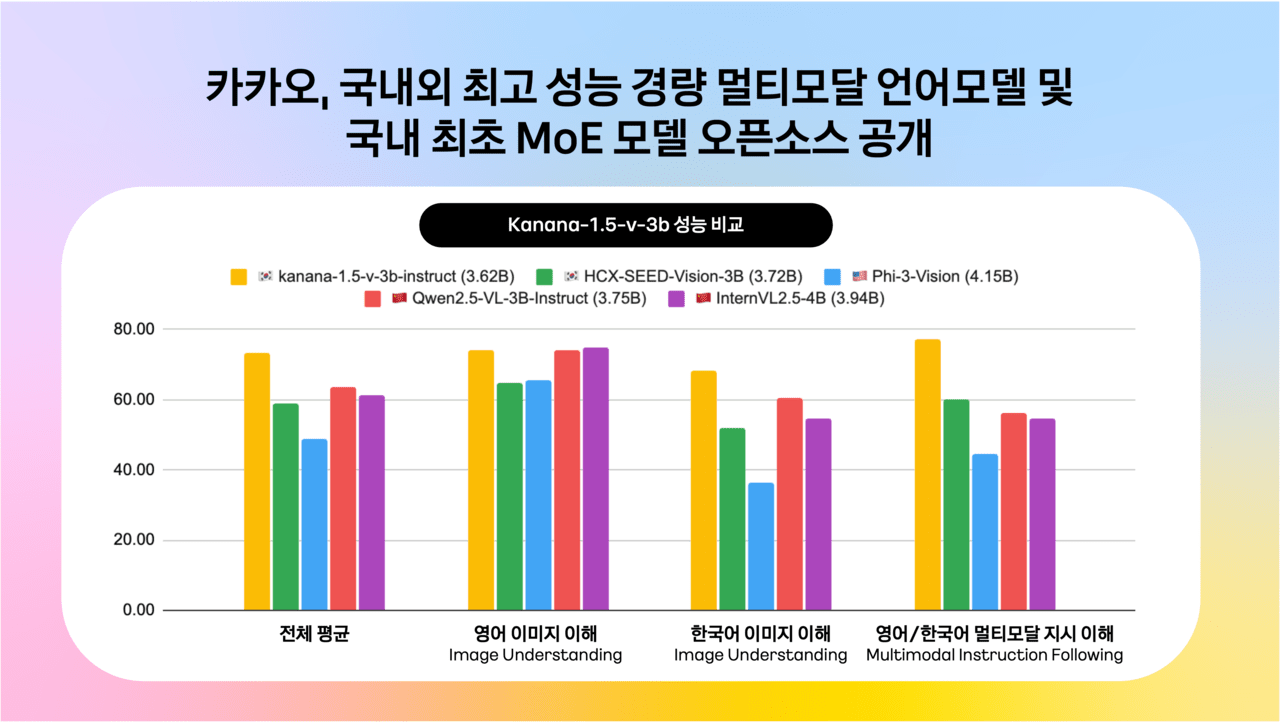

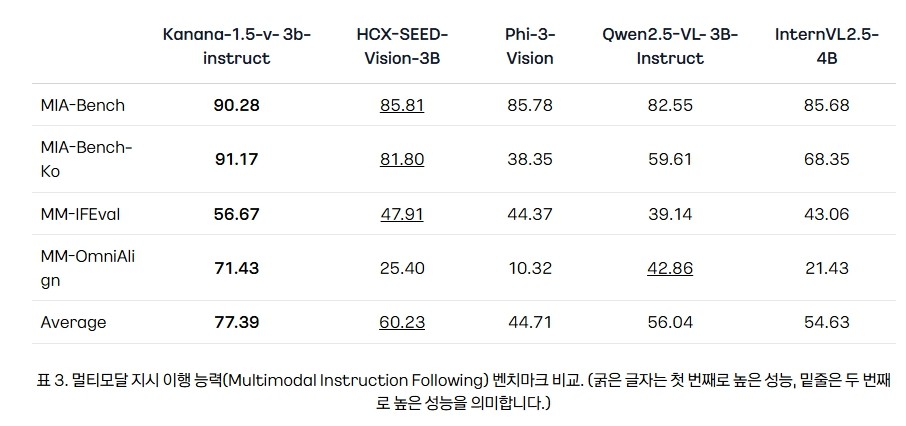

기술보고서를 통해 벤치마크도 공개했다. 여기에는 네이버 '하이퍼클로버X-시드-V-3B'와 마이크로소프트의 '파이-3', 알리바바의 '큐원 2.5', 중국 오픈GV랩의 '인턴VL2.5' 등이 비교 대상으로 등장했다.

이중 출시된 지 얼마 안 된 국내 모델로, 매개변수가 같은 하이퍼클로버X-시드-V-3B와의 비교가 주목됐다.

카나나는 멀티모달 추론 능력(MIA-Bench), 한국어 멀티모달 추론능력(MIA-Bench-Ko), 멀티모달 지시 이행 능력(MM-IFEval),멀티모달 인간선호도(MM-OmniAlign) 등에서 모두 네이버 모델을 앞선 것으로 나타났다.

또, 한국어 문자인식능력(KoOCRBench)에서는 하이퍼클로바X의 두배가 넘는 점수를 기록했다.

카카오는 "한국어 문자인식 및 해석 능력에서 큰 격차를 보여주었으며, 이는 실제 서비스 환경에서 활용 가능성을 높이는 중요한 요소"라고 강조했다.

한편, 하반기에 에이전트형 AI 구현에 필수적인 추론 모델의 성과도 공개할 예정이라고 전했다.

카카오는 이 날 MoE 아키텍처를 적용한 ‘카나나-1.5-15.7b-a3b’도 함께 공개했다.

보고서에 따르면 이 모델은 "핵심 목표는 적은 활성 파라미터만으로 훨씬 큰 수준의 Dense 모델에 준하는 성능을 구현하며 추론 효율성을 극대화하는 것"이며, 37% 수준에 불과한 활성 매개변수만으로도 카나나-1.5-8B과 대등한 성능을 보였다고 설명했다.

모델 학습 시간과 비용을 절약하기 위해 3B 규모의 카나나-나노-1.5-3B’에 업사이클링(Upcycling) 방식을 적용해 개발했다.

카카오는 이번 MoE 모델은 고성능 AI 인프라를 저비용으로 구축하고자 하는 기업이나 연구 개발자들에게 도움이 될 것이며, 저비용·고효율 서비스 구현에 유리하다고 덧붙였다.

김병학 카나나 성과리더는 “이번 오픈 소스 공개는 비용 효율성과 성능이라는 유의미한 기술 개발의 성과를 거둔 것으로, 단순한 모델 아키텍처의 진보를 넘어 서비스 적용과 기술 자립이라는 두 가지 측면의 목표에 부합하는 결과물”이라고 말했다.

박수빈 기자 sbin08@aitimes.com