메타가 휴대폰이나 엣지 장치용으로 설계된 초소형 추론 특화 모델 ‘모바일LLM-R1(MobileLLM-R1)’을 공개했다.

메타는 최근 온디바이스 추론 애플리케이션을 위해 최적화된 소형언어모델(sLM) ▲모바일LLM-R1-140M ▲모바일LLM-R1-350M ▲모바일LLM-R1-950M를 오픈 소스로 출시했다.

각각 1억4000만, 3억5000만, 9억5000만 매개변수 규모의 추론 특화 소형 모델로, PC나 휴대폰 등 제한적인 메모리와 에너지 용량의 로컬 환경에서 구동 가능하다. 수학·코딩·과학 추론 전문으로, 일반 채팅용에는 적합하지 않다.

메타는 10억개 미만의 적은 매개변수를 가진 추론 모델을 최적화하기 위해 ‘그룹 쿼리 어텐션(GQA), 블록 단위 가중치 공유, SwiGLU 활성화 함수 등을 적용해 연산과 메모리 요구량을 최소화하면서도 성능을 끌어올렸다고 밝혔다.

컨텍스트 창은 기본 4000 토큰이며, 사후 학습을 거치면 최대 3만2000 토큰까지 확장 가능하다. 학습에는 5조 토큰이 사용됐으며, '라마-3.1-8B-인스트럭트' 데이터 증류를 통해 추론 성능을 강화했다.

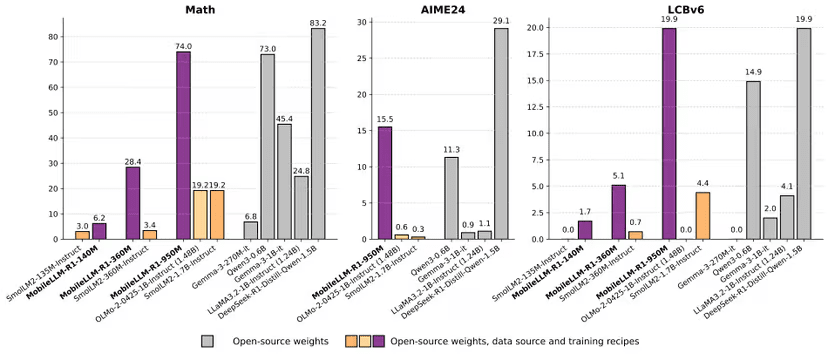

벤치마크 성과도 눈에 띈다. 수학 능력 테스트인 '매스(MATH)' 테스트에서 950M 모델은 74.0점을 기록해 알리바바의 '큐원3-0.6B(73.0점)'를 소폭 앞섰다.

코딩 성능을 측정하는 '라이브코드벤치(LiveCodeBench)'에서는 19.9점을 얻어, 큐원3-0.6B(14.9점)를 크게 넘어섰다. 이는 36조 토큰을 학습한 큐원3보다 8.6배나 적은 데이터를 학습해 비슷하거나 더 나은 성과를 낸 것이다.

모바일LLM-R1은 허깅페이스를 통해 오픈 소스로 배포되지만, 상업적 활용은 허용되지 않으며 연구 및 내부용에 한정된다.

한편, 이번 모델을 출시한 메타 FAIR는 최근 슈퍼인텔리전스 랩(MSL)의 조직으로 편입됐다. MSL에서는 '라마 4.5'를 비롯해 차세대 모델을 개발 중인 TBD 랩에 외부 영입 멤버들이 집중돼 있다.

박찬 기자 cpark@aitimes.com