구글 딥마인드가 로봇이 행동에 앞서 문제를 생각하고 계획을 세워 복잡한 다단계 작업을 수행할 수 있도록 설계된 ‘제미나이 로보틱스 1.5(Gemini Robotics 1.5)' 군을 공개했다. 이번에는 웹 검색까지 활용, 더 복잡하고 정교한 작업이 가능해졌다는 설명이다.

구글 딥마인드는 25일(현지시간) 추론(VLM) 기반의 ‘제미나이 로보틱스-ER 1.5’와 행동(VLA) 기반의 ‘제미나이 로보틱스 1.5’ 모델을 공개했다.

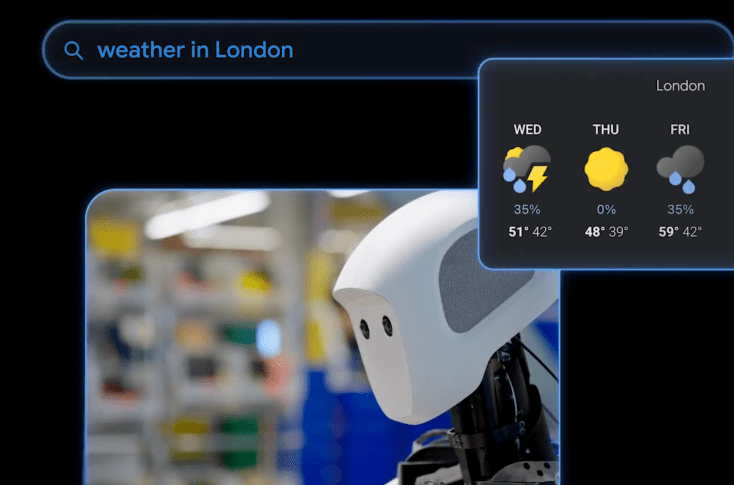

제미나이 로보틱스-ER 1.5는 물리적 환경을 이해하고 추론을 통해 다단계 계획 수립과 논리적 의사결정을 담당하는 로봇의 '두뇌' 역할을 한다. 이 과정에 웹 검색과 같은 외부 도구도 활용한다.

이번 모델은 지난 3월 '체화 추론'에 최적화된 최초의 사고 모델이라고 발표한 ER 1.0 버전에 이어 나온 것이다. 이 버전에서는 로봇이 종이접기나 가방 지퍼 열기와 같은 비교적 단순한 작업을 수행했다.

그러나, 이제는 진한 색상과 연한 색상으로 세탁물을 분류하는 것은 물론, 현재 날씨에 맞춰 가방을 쌀 때 우산을 포함할 수 있다. 쓰레기를 구분할 때 해당 지역 기준을 웹 검색으로 검색, 폐기물과 재활용품과 구분하는 일 등이 가능해졌다.

카롤리나 파라다 딥마인드 로보틱스 책임자는 “지금까지 모델은 한번에 한가지 지시를 수행하는 데 능숙했지만, 이번 업데이트로 로봇이 실제 물리적 작업을 이해하고 문제를 해결할 수 있게 됐다”라고 말했다.

이어, 제미나이 로보틱스 1.5는 ER 모델로부터 받은 자연어 결과를 동작 명령으로 변환한다. 이처럼 두 모델이 협업 방식으로 작동한다.

다른 로봇 구조 간에도 동작 전이(Motion Transfer)도 가능해, 새로운 로봇에서도 추가 학습 없이 작업 수행이 가능하다. 예를 들어, 프랑카 로보틱스의 로봇 팔과 앱트로닉의 휴머노이드 로봇 아폴로에서 바로 작동한다.

15가지 체화 추론 벤치마크에서 기존 ER 1.0 버전은 물론, 오픈AI의 'GPT-5'를 앞선 최고 성능을 달성했다고 전했다.

제미나이 로보틱스-ER 1.5는 구글 AI 스튜디오의 제미나이 API를 통해 개발자에게 제공되며, 제미나이 로보틱스 1.5는 일부 파트너에게만 제공된다.

구글은 로봇이 사람 행동을 관찰해 스스로 기술을 학습하는 기능과 정교한 손재주, 안정성과 안전성 확보 등 해결할 과제가 여전히 남아 있다고 밝혔다.

박찬 기자 cpark@aitimes.com