인공지능(AI)이 사진을 넘어 ‘영상’을 인식하는 시대가 도래한다. AI가 ‘이미지’뿐 아니라 영상 속 ‘음성’과 시시각각 변하는 ‘장면 전환’까지 인식하며 보다 현실세계를 인지하는 능력을 갖춰나가고 있는 지점이다.

페이스북 AI 연구소(FAIR)는 블로그를 통해 12일(현지시간) 컴퓨터 비전 관련 두 가지 소식을 전했다. AI 영상 인식 기술을 기반으로 인스타그램 릴즈(Reels, 15~30초 이내 짧은 영상) 추천 시스템을 구축했다는 것과 영상에 특화된 딥러닝 모델 ‘타임스포머(TimeSformer)'를 개발했다는 소식이다.

릴즈 추천 시스템은 ‘영상으로 배우다(Learning from Videos)’ 프로젝트의 일환으로 구축됐다. 시스템의 골자는 영상 속 이미지와 음성을 연계해 분석하는 AI 모델을 개발했다는 것이다.

타임스포머는 영상 속 이미지 인식·처리에 특화된 AI 모델이다. 영상이 재생되는 시간동안 대상이 공간상에서 움직이는 것을 인식한다. AI가 ‘시공간’ 이해에 한발 더 나아간 모습이다.

◆눈과 귀 연결되는 AI... 시청각 능력으로 세상 바라본다

릴즈 추천 시스템의 AI는 영상을 ‘음성’과 ‘이미지’ 데이터를 종합적으로 분석한다.

릴즈에는 춤을 추거나 연기하는 영상 콘텐츠가 주를 이룬다. 이때 콘텐츠 제작자는 자신의 영상에 배경 음악을 삽입한다. 숏폼 콘텐츠 플랫폼 틱톡과 유사한 장르다.

콘텐츠에는 같은 배경음악을 이용한 콘텐츠가 많지만 영상에 등장하는 인물이나 영상 내용은 각기 다르다. 추천 시스템 기준을 음악 혹은 이미지만으로 선정할 수 없는 이유다.

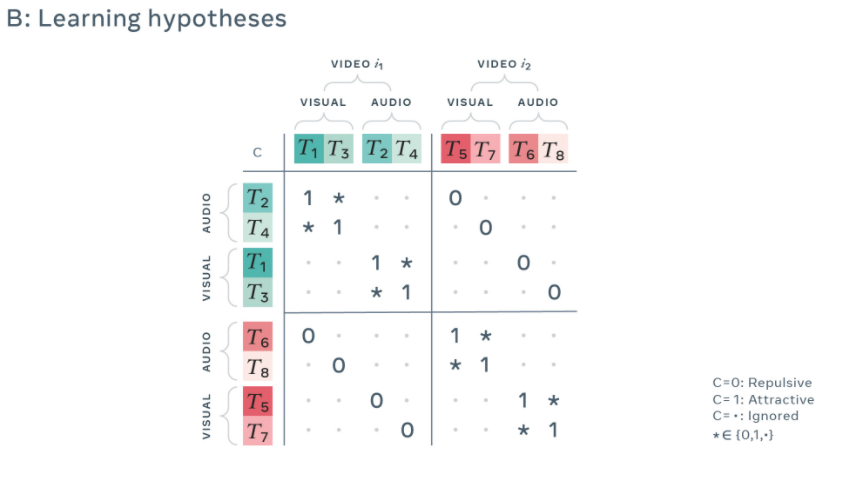

페이스북은 효율적인 릴즈 추천 시스템을 구축하기 위해 시청각 자료를 모두 아우르는 GDT(Generalized Data Transformations) 모델을 적용했다.

GDT는 영상-음성 관계를 인식하는 딥러닝 모델로 페이스북이 지난해 6월 처음 공개했다.

다중모드 데이터(Multimodal Data)를 학습하는 GDT는 시청각 자료 인식이 가능하다. 다중모드 데이터란 영상, 음성 등 단일 데이터가 아닌 여러 데이터 간 상관관계를 담고 있는 정보를 뜻한다.

GDT는 합성곱신경망(CNN, Convolutional Neural Network) 원리를 활용하는데 데이터 학습 시 서로 관계있는 정보는 벡터 공간상에 가깝게 배치하며, 무관한 정보는 멀리 배치한다.

영상 속 이미지와 무관한 음성 데이터(소음, 잡음) 등은 벡터 공간상 멀리 배치해 기계학습 시 두 데이터 간 관계를 낮게 분석하는 식이다.

이때 벡터 공간이란 AI가 데이터를 인식할 수 있도록 각 정보를 수계로 표현한 행렬 혹은 그래프를 의미한다.

이에 릴즈 추천 시스템은 소리는 비슷하지만 영상 내용이 다른 콘텐츠를 선별할 수 있다.

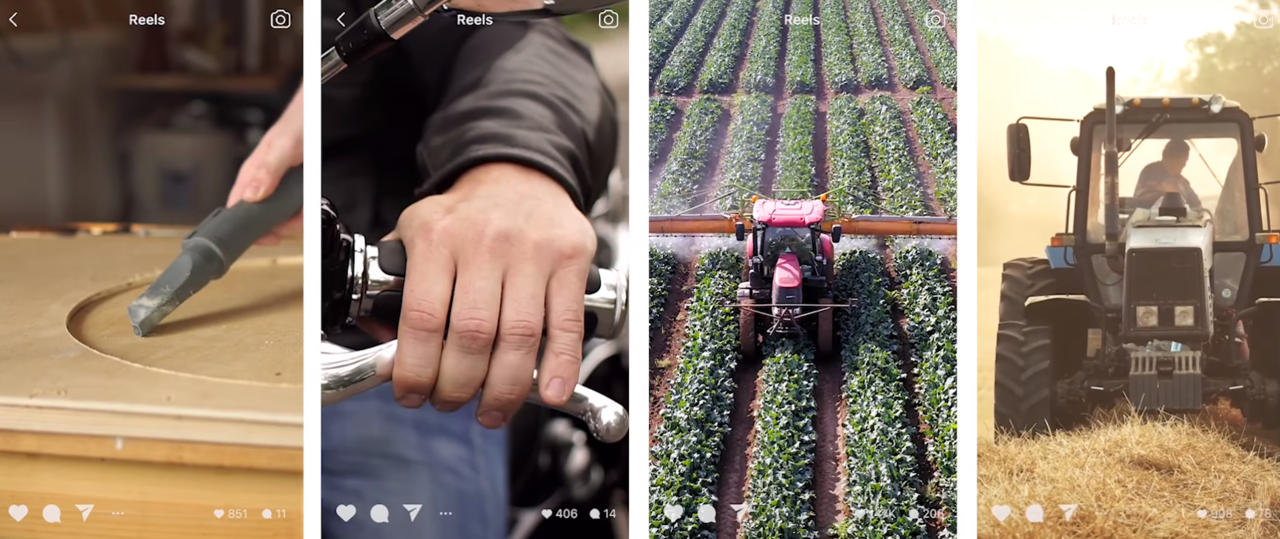

청소기, 오토바이, 트랙터가 등장하는 영상에는 비슷한 엔진 작동 소리가 들어간다. 하지만 영상 내용은 다른 경우가 있다. 추천 시스템은 이렇듯 소리는 비슷하지만 이미지는 다른 영상을 ‘중복’되지 않았다고 선별해준다.

같은 배경음악을 활용한 릴즈 콘텐츠에서 등장인물이나 콘텐츠 내용이 다르다면 중복 콘텐츠로 여기지 않고 이용자에게 추천해줄 수 있다.

◆보고, 듣고, 읽기까지... 다각적 인지 능력 갖춰가는 AI

영상 인식을 위해 FAIR는 AI의 ‘음성 인식 능력’을 업그레이드한다. 뿐만 아니라 영상 속 텍스트 추출·인지 능력까지 더해 ‘보고, 듣고, 읽는’ AI를 개발한다.

FAIR는 AI의 음성 인식률을 높이기 위해 Wav2vec 2.0 기술을 활용했다. Wav2vec 2.0은 입력한 ‘원시 음성데이터’를 기반으로 자기지도학습을 거쳐 데이터를 더 정확하게 인식해내는 딥러닝 모델이다.

원시 데이터를 활용할 때 장점은 ‘음성’을 그대로 학습한다는 점이다. 국적별로 다른 뉘앙스나 사람마다 다른 말투를 있는 그대로 학습한다. 아이가 빠르게 언어를 습득하지만 사전에 표기된 발음 기호를 일일이 익혀가며 공부하지 않는 원리와 같다.

FAIR는 Wav2vec 2.0 기술을 수백만 시간 분량의 원시 데이터와 100시간 분량 라벨링된 데이터에 각각 적용했다. 이에 원시 데이터 기반 테스트에서 단어 인식 오류가 20% 적다는 결과를 얻어냈다.

‘듣는’ 능력뿐 아니라 ‘읽는’ 능력까지 갖춰나간다.

FAIR는 음성과 텍스트 간 연계 정보를 학습하기 위해 AVT(Audio Visual Textual)라는 모델을 활용했다.

AVT는 시청각자료에서 ‘텍스트’ 자료를 수집하는 음성 인식 출력 모델이다. 영상 속 음성을 텍스트 자료로 추출해 해당 이미지와 연계한다.

이에 텍스트 명령을 통한 영상 검색 기능 등이 가능해진다. AI에게 “할머니에게 노래 불러주던 영상을 보여줘”라는 ‘텍스트’ 명령어를 입력하면 AI는 관련 ‘영상’을 찾아 제시할 수 있게 된다.

◆타임스포머 아키텍처... ‘시공간’ 이해하는 AI 시대

FAIR는 ‘행동 인식’이 가능한 아키텍처 타임스포머를 개발했다.

AI가 시간 흐름에 따라 움직이는 대상을 감지해 ‘시공간’적 인식 능력을 갖췄다고 평가할 수 있는 지점이다.

타임스포머 관련 연구 논문 ‘영상 이해를 위해 시공간 주의집중이 필요한가?(Is Space-Time Attention All You Need for Video Understanding?)’은 지난달 9일 논문 데이터베이스 아카이브(arXiv)에 올라왔다.

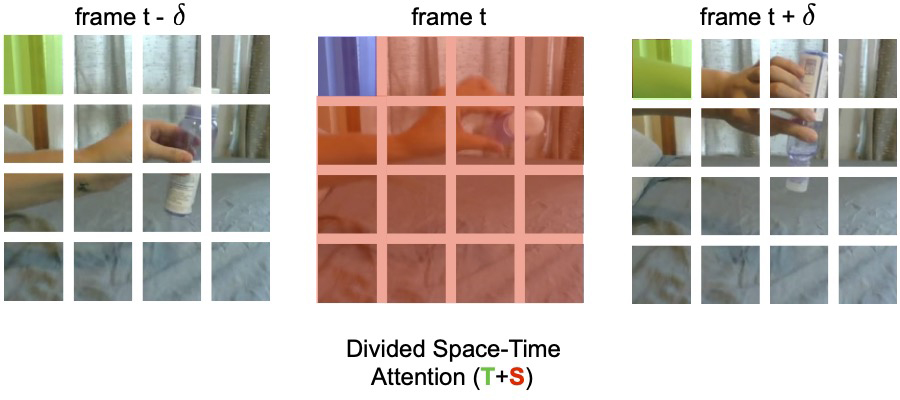

타임스포머는 시간과 공간을 구분해 분석하는 것이 아닌 ‘시공간’을 통합해 분석하는 딥러닝 모델이다.

영상 프레임을 여러 패치 단위로 구역을 나눠 움직임이 보이는 곳만을 주목해 인식한다. 기존 움직임을 인식하기 위해 쓰였던 방법인 3D 합성곱신경망 학습이 프레임 전체를 학습했던 것과 다른 점이다.

타임스포머는 움직임이 담긴 패치만을 골라 다음 프레임에서 그 움직임이 얼마큼 변했는지 분석한다. 이때 패치 상에서 움직임이 포착된 시간만큼만 비교 분석을 진행한다.

타임스포머의 장점은 효율성이다. 프레임 전체 영역을 분석할 필요가 없어, 영상 속 움직임을 인식하는데 기존의 방법보다 더 짧은 시간이 걸린다.

FAIR는 타임스포머를 통해 앞선 방법보다 영상 인식을 위한 학습 시간이 약 1/3으로 줄어들며 컴퓨팅 메모리양은 1/10로 줄어든다고 설명했다.

기존 3D 합성곱신경망이 10초 내 영상만을 처리하지 못했던 것과 달리 타임스포머의 경우 최대 몇 분에 걸친 영상을 인식·처리할 수 있다.

인식할 수 있는 영상데이터 분량이 늘어났다는 점은 영상을 더 정확히 구분할 수 있음을 뜻한다. 예를 들어 요리의 겨우 그릇에 계란을 푸는 장면만으로는 어떤 요리인지 구분할 수 없다. 대부분의 요리 과정에 계란 푸는 장면이 있기 때문이다.

FAIR측은 “컴퓨터비전에 소모되는 시간과 컴퓨팅 메모리양을 타임스포머로 줄여냈다”라며 “앞으로 AR/VR을 기반으로 하는 미래 서비스에서 실시간 영상 처리 앱을 지원할 수 있는 중요한 단계다”라고 말했다.

AI타임스 장희수 기자 heehee2157@aitimes.com

[관련기사]이미지 인식 AI, 'SEER'와 'CLIP'... 스스로 학습에 연상 능력까지 갖춰

[관련기사]서울대, 국제 '컴퓨터비전·패턴인식' 학회서 '17편' 역대 최다 논문 채택...논문 수, 카이스트와 양강 구도