사람들이 친구나 가족, 직장에서 상황에 맞춰 다르게 행동하듯이, 인공지능(AI) 시스템도 다양한 사회적 상황에 맞게 행동과 말을 조정하는 '적절성(Appropriateness)' 모델이 개발됐다.

구글 딥마인드와 밀라 연구소, 토론토 대학교, 막스 플랑크 연구소 연구팀은 4일(현지시간) AI가 다양한 상황에 맞는 출력을 생성하는 '적절성' 모델에 대한 논문을 아카이브에 게재했다.

적절성은 사람들의 행동과 의사결정을 이끄는 기준으로, 각 상황에 맞춰 자연스럽게 조정된다. 생성 AI에서도 적절성은 중요한 역할을 한다. AI가 콘텐츠를 생성할 때에도 적절성을 고려해야 하는데, 그 기준은 사람이나 상황마다 다를 수 있다. 예를 들어, 교육용 챗봇은 성인용 게임 챗봇과는 다른 방식으로 행동해야 한다.

연구진은 AI가 인간의 행동 규범에 맞춰 적절하게 행동하는 방법을 제시하고, 적절성을 사회적 결속을 위한 변화하는 규칙으로 다뤘다. 이들은 AI가 전통적인 도덕적 기준을 따르기보다는, 변화하는 다양한 사회적 규범에 맞춰 적응해야 한다고 주장한다.

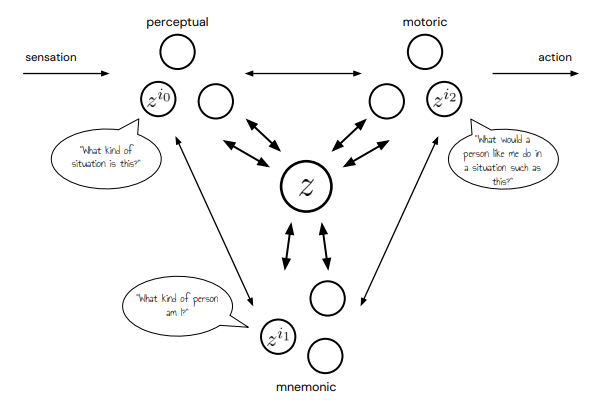

연구에서는 사람들이 상황에 맞는 적절한 행동을 결정하는 과정을 설명하는 모델을 제시한다. 이 모델은 사람들이 기억과 상황에 맞는 단서를 바탕으로 적절한 행동을 예측한다고 가정한다. 이를 위해 감각 정보와 과거 경험을 결합해 의사결정을 돕는 시스템을 포함하고, 사회적 규범과 관습이 사람들의 판단에 미치는 영향을 설명한다. 최종적으로 AI가 복잡한 사회적 상황을 잘 처리할 수 있도록 돕는 것을 목표로 한다.

이 연구는 인간 행동을 '정렬' 차원이 아닌 '적절성'의 관점에서 분석하며, 상호 작용에서는 갈등을 해결하는 방식이 우선이라는 점을 강조한다. 이는 기존 AI 모델의 우선 순위와는 조금 다르다.

또 기존의 보상 기반 접근법과는 다른 방식으로 의사결정을 설명하며, 인간 행동에서 적절성은 여러 사회적 영향들이 결합된 결과로 나타난다고 설명한다.

연구진은 "AI 적절성에 대한 판단은 궁극적으로 인간이 내리기 때문에, AI는 적절성이 인간의 의사 결정이 어떻게 이뤄지는지 이해해야 한다"라며 "적절성이 생성 AI 기술의 책임감 있는 배포에 어떤 의미가 있는지를 보여주는 이론"이라고 밝혔다.

박찬 기자 cpark@aitimes.com