중국 인공지능(AI) 업계가 엔비디아의 'H20' 수입 자제 권고로 재활용·중고 GPU로 눈을 돌리고 있다.

27일 디지타임스에 따르면, 중국 기업들은 최근 'A100'과 'H100' 등을 분해하고 재구성해 '저비용·고성능' 맞춤형 추론 시스템으로 활용하는 것이 유행이다. 이 때문에 출시된 지 몇년된 구형 GPU의 수요가 급증하는 것으로 나타났다.

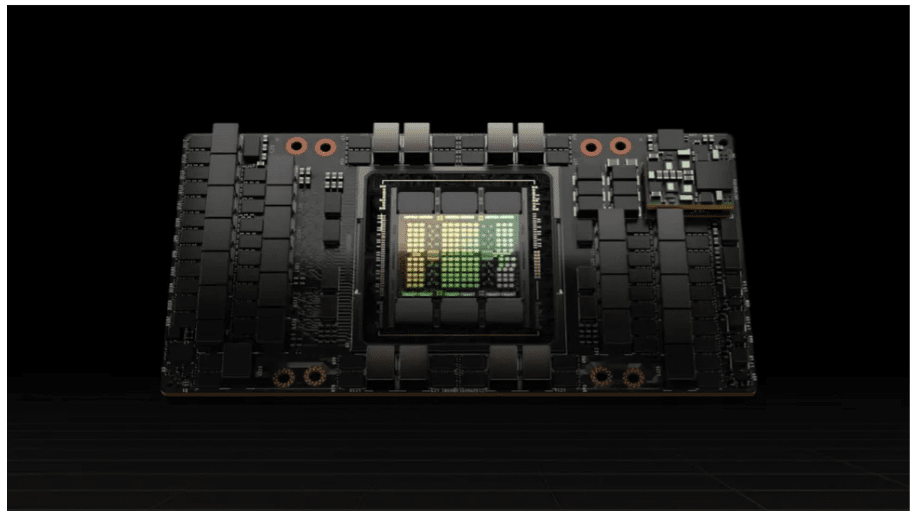

추론, 즉 서비스는 모델 학습보다 연산 부담이 적어, 일부 정밀 연산을 줄인 하드웨어에서도 효율적으로 구동될 수 있다. 2020년 출시된 A100은 암페어(Ampere) 아키텍처 기반으로 최대 80GB HBM2e 메모리와 초당 2테라바이트(TB) 대역폭을 갖추고 있어, 최신 GPU에 비해 학습 성능은 낮지만 메모리와 CUDA 소프트웨어 지원 덕분에 추론 작업에서는 여전히 효율적이다.

2022년 출시된 H100은 블랙웰 출시 전까지는 엔비디아 주력 모델이었다. A100에 비해 최대 6배 높은 학습 처리량을 제공한다.

반면, H20은 추론용으로 성능을 크게 줄였기 때문에, 풀스펙 H100 대비 AI 성능이 3~7배 낮고 FP64 슈퍼컴퓨팅 작업에서는 30배 이상 느리다. 이 때문에 중국 기업 입장에서는 H20보다 A100을 재활용하는 것이 더 매력적이다.

여기에 엔비디아의 CUDA 생태계가 여전히 압도적이기 때문에, 구형 GPU는 개발자들이 바로 활용할 수 있으며 낮은 정확도 손실 위험으로 장시간 구동도 가능하다.

하지만 이런 상황은 엔비디아로서는 딜레마. 중고 시장의 확산은 엔비디아의 매출을 줄이고 최신 아키텍처 채택을 저해할 위험이 있다.

중국 정부 입장에서도 문제다. 화웨이와 비렌 등 중국산 칩 사용 확대를 원하고 있지만, 재활용 GPU가 이를 방해할 수 있기 때문이다.

결국 이번 사태는 수출 규제 강화가 가져온 의도치 않은 결과를 보여준다는 평이다.

미국은 엔비디아 칩을 통해 중국의 기술 의존도를 높이려는 의도를 가지고 있으며, 중국은 엔비디아 칩을 억제해 기술 자립을 이루려고 애쓰고 있다. 그러나 현실은 출시된 지 몇년 된 A100과 H100이 여전히 AI 시스템을 구동하는 ‘재활용 경제’가 형성된 것이다.

박찬 기자 cpark@aitimes.com