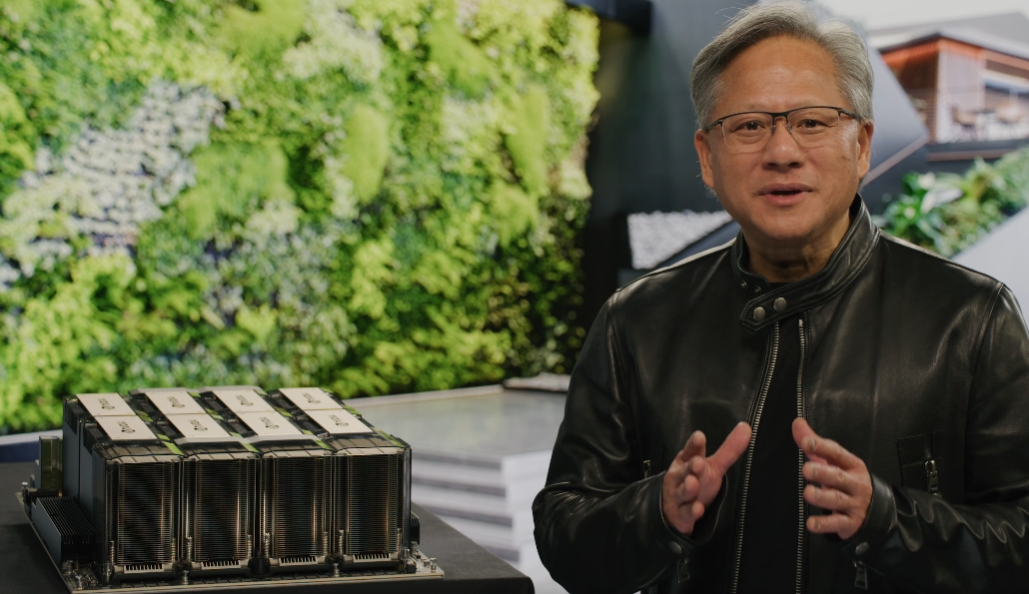

엔비디아가 생성 인공지능(AI)을 위한 추론 플랫폼의 핵심으로 꼽히는 ‘호퍼’ 아키텍처 기반 H100 GPU 제품군을 확장했다고 21일(현지시간) GTC 2023에서 발표했다.

차세대 제품 H100 GPU는 엔비디아의 최신 A100 GPU보다 12배나 빠르다는 설명이다. 오라클 클라우드 서비스에 H100 GPU 1만6000개, 아마존 웹서비스(AWS)에는 최대 2만개의 GPU를 탑재했으며, 마이크로소프트(MS) 애저나 구글 클라우드에도 H100 GPU를 적용한 서비스를 제공하고 있다고 밝혔다.

AI 모델을 실제 서비스에 적용하는 '추론(inference)' 플랫폼은 최근 챗GPT나 스테이블 디퓨전 등 생성 AI의 형태로 주류를 이루며 큰 시장을 형성했다.

엔비디아는 이런 생성 AI 추론 플랫폼에 적용할 수 있는 호퍼 아키텍처 기반 GPU의 신제품을 선보여 포트폴리오를 확장했다고 전했다.

특히 ▲비디오와 이미지 생성을 비롯해 ▲대형언어모델(LLM) ▲실시간 추천 시스템 등의 주요 AI 추론 영역을 위한 네 개의 플랫폼을 단일 아키텍처 기반으로 확보했다고 밝혔다.

우선 ‘L4’ GPU는 AI 비디오 워크로드에 효율적으로 활용할 수 있다. 대부분 서버에서 사용 가능한 물리적 호환성을 가지고 있으며, CPU 대비 120배의 성능을 제공한다. 현재 구글 클라우드, 런치패드 등 파트너들이 사용하고 있다.

‘H100 NVL’ GPU는 실시간 LLM 추론 환경에 효과적이며, PCIe 버스 기반의 폼팩터로 설계돼 다양한 범용 서버에서 사용 가능하다. GPT3-175B 추론 성능에서는 기존 HGX A100 대비 10배의 성능을 제공하며, GPU 메모리는 기존 80GB보다 2.4배 늘어난 188GB다.

GPU 메모리 대역폭은 HBM3를 사용해 기존보다 3.8배 높아진 초당 7.8TB를 제공한다. FP16, FP8 텐서코어 성능은 H100 대비 2.6배 높다고 전했다.

더불어 엔비디아는 중국 수출용으로 합법화하기 위해 H100 칩의 일부 기능을 축소한 H800 칩을 개발했다고 밝혔다.

미국 규제당국은 지난해 국가 안보 문제를 이유로 중국에 엔비디아의 A100과 H100 등을 판매하지 못하도록 하는 규정을 마련했다. 이런 칩은 오픈AI의 챗GPT 같은 생성 AI를 개발하는 데 핵심 요소로 꼽힌다.

엔비디아는 "H800이 수출 통제 규정을 완전히 준수한다"고만 밝혔을 뿐, 구체적인 사양은 공개하지 않았다.

그러나 중국 칩 업계에 따르면 H800은 칩 간 데이터 전송 속도를 H100 속도의 약 절반으로 줄인 것으로 알려졌다.

엔비디아는 이 칩이 현재 알리바바, 바이두, 텐센트와 같은 중국 빅테크의 클라우드 컴퓨팅 유닛에서 사용되고 있다고 덧붙였다.

박찬 위원 cpark@aitimes.com

- 생성 AI 등장...승자는 엔비디아?

- MS-엔비디아, 클라우드 AI 슈퍼컴퓨터 구축 맞손

- 엔비디아, AI 벤치마크 테스트에서 세계 기록 경신

- 엔비디아, 생성AI 개발 지원하는 클라우드 서비스 공개

- 엔비디아, 구글 클라우드를 통해 생성 AI 플랫폼 제공

- 10년 동안 100만배 성장한 인공지능..."예상치 못한 현실"

- 슈퍼마이크로, 엔비디아 오피스용 수냉식 AI 개발 플랫폼 도입

- 생성 AI 예술을 위한 아트 갤러리 오픈

- 생성AI 돌풍으로 'H100' 가격 폭등...대당 최대 6000만원 호가

- MS, 자체 AI 칩 ‘아테나’ 이르면 내년 초 출시

- 엔비디아, 환각현상 방지 도구 '네모 가드레일' 오픈소스로 공개

- 엔비디아, 'DGX H100' 본격 출하

- 엔비디아 2분기 매출 14조5000억원 예상, 주가 급등

- 테크에이스 소프트웨어, 국내 및 아시아 전역에 AI 고성능 핵심 장비 공급