국내 LLM 대표 기업 중 하나인 올거나이즈가 '알파-인스트럭터'라는 소형LLM(sLM)을 출시했습니다.

이 모델은 메타의 '라마3'를 기반으로 하며 매개변수는 80억개에 불과합니다. 하지만 올거나이즈의 기술로 한국어 능력이 탁월하다는 설명입니다.

특히 이 회사는 데이터의 중요성을 강조했습니다. 미세조정 과정에서도 학습 데이터의 퀄리티를 높이는 데 주력했다고 밝혔습니다.

심지어 "퀄리티 관리가 되지 않은 대량의 데이터를 쓰느니, 소규모의 질 좋은 데이터로 학습하는 게 더 낫다고 생각한다"라며 "OPRO로 멀티언어 미세조정을 진행한 타 모델의 논문들에서도 비슷한 결론을 내고 있다"라고 전했습니다.

이는 이미 국내외에서 공통으로 지적하는 상황입니다. 해외 유명 연구소의 과학자들은 "AI 모델 성능의 핵심은 디자인이나 아키텍처가 아닌, 데이터셋" "모든 모델이 같은 데이터셋으로 충분한 시간 학습하면, 성능은 거의 같아질 것" "안정적인 훈련 설정 단계애 접어들면 성능 향상은 데이터에서 나온다" 등의 의견을 밝히고 있습니다.

올거나이즈처럼 적은 매개변수를 가진 모델이 훨씬 큰 모델보다 뛰어난 성능을 보이는 경우가 최근 부쩍 늘었는데, 이는 데이터셋의 품질이 좋아졌기 때문이라는 설명입니다.

인간으로 따지자면 좋은 책 몇권을 제대로 읽은 학생이 아무 책이나 닥치는 대로 읽은 학생보다 성적이 좋아진다는 의미입니다. 당연한 말입니다.

데이터가 중요하다는 것은 AI의 기본 상식입니다. 하지만 최근 데이터가 다시 강조되는 것은 요즘 고품질 데이터를 구하는 것이 점점 어려워진다는 지적 때문입니다.

대부분 저작권자들은 자신들의 데이터가 합당한 가격에 사용되길 바라고 있습니다. 이 때문에 오픈AI나 구글 등은 연간 수백만달러를 지급하고 뉴스 등을 가져다 쓰고 있습니다. 심지어 이제까지 저작권 문제에 무대응으로 일관하던 메타조차 데이터셋 품질 저하 때문에 돈을 내는 것을 검토 중이라고 합니다.

반면 이런 자금력을 갖추지 못한 곳은 점점 AI 발전을 따라가기 어려워질 것이 뻔합니다.

최근 국내에서 열렸던 데이터 관련 컨퍼런스에서도 이런 점이 집중적으로 다뤄졌습니다. 또 이 때문에 업스테이지 같은 곳은 LLM 구축에 앞서 데이터 문제부터 해결하려고 시도했습니다.

이 때문에 LLM은 사실상 대기업의 독점 사업이 돼가는 것이 아는가 하는 우려가 나오고 있습니다. 비싼 GPU를 구하기도 어려운 데다, 데이터 가격까지 치솟고 있기 때문입니다. 그야말로 'AI 군비 경쟁'이라는 말이 실감나는 현실입니다.

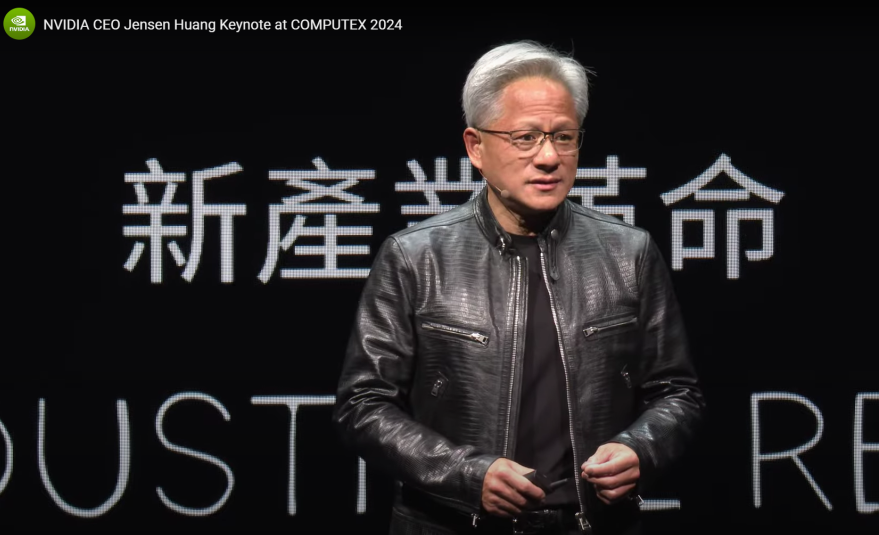

■ 젠슨 황이 밝힌 'CEO의 수학'...“GPU 많이 살수록 많이 절약”

젠슨 황 엔비디아 CEO가 대만 컴퓨텍스에서 그럴싸한 멘트를 남겼습니다. GPU를 많이 살수록 기업에서는 비용 절감 효과가커진다는 것인데, 이를 'CEO의 계산법'이라고 불렀습니다.

■ AMD, 엔비디아 추격용 AI 칩 4분기 출시 계획

AMD가 엔비디아 GPU를 따라잡기 위해 엔비디아를 밴치마킹했습니다. 즉 AI 가속기를 매년 업그레이드, 출시하겠다는 겁니다.

비전 AI 기술을 이용해 하늘을 나는 드론을 백발백중 격추하는 기술이 등장했습니다. 이 회사는 사람에게 적용할 것을 우려, 절대로 경찰에는 기술을 판매하지 않겠다고 합니다.

AI타임스 news@aitimes.com