메타가 4050억 매개변수를 가진 역대 최대 규모의 오픈 소스 AI 모델 ‘라마 3.1’를 공개했다. 이 모델이 오픈AI의 'GPT-4o', 앤트로픽의 '클로드 3.5 소네트' 등 현존 최고 성능의 모델과 맞먹는 수준이라고 강조했다.

벤처비트는 23일(현지시간) 메타가 역대 최고 성능의 오픈 소스 AI 모델 ‘라마 3.1’ 제품군을 출시했다고 소개했다. 이날 처음 선보인 가장 큰 모델인 매개변수 4050억개의 ‘라마 3.1 405B’는 오픈 소스 모델 중 역대 최대 규모다.

지난 4월 ‘라마 3′ 소형 버전을 선보인 후 3개월여만이다. 당시 출시한 '라마 3 8B'와 '라마 3 70B' 모델도 ‘라마 3.1 8B’, ‘라마 3.1 70B’로 업그레이드했다.

라마 3.1 제품군 3종은 공통으로 8개 언어 대화가 가능하다. 영어를 포함해 아랍어, 벵골어, 독일어, 힌디어, 포르투갈어, 태국어, 스페인어 등이 여기에 포함된다.

또 높은 수준의 컴퓨터 코드를 작성할 수 있을 뿐만 아니라, 이전 버전보다 더 복잡한 수학 문제를 풀 수 있다고 소개했다.

라마 3.1 모델 학습에는 15조개 이상의 토큰이 사용됐으며, 컨텍스트 창 크기가 12만8000 토큰으로 기존 버전에 비해 16배 늘었다. 12만8000토큰은 대략 50페이지 분량의 책 한권 분량이다.

라마 3.1 405B 모델은 기업들이 합성 데이터셋을 만드는 데 사용할 수 있도록 라이선스를 변경했다. 이를 통해 생성한 데이터셋은 작은 오픈 소스 모델을 훈련하거나 미세 조정하는 데 사용할 수 있다.

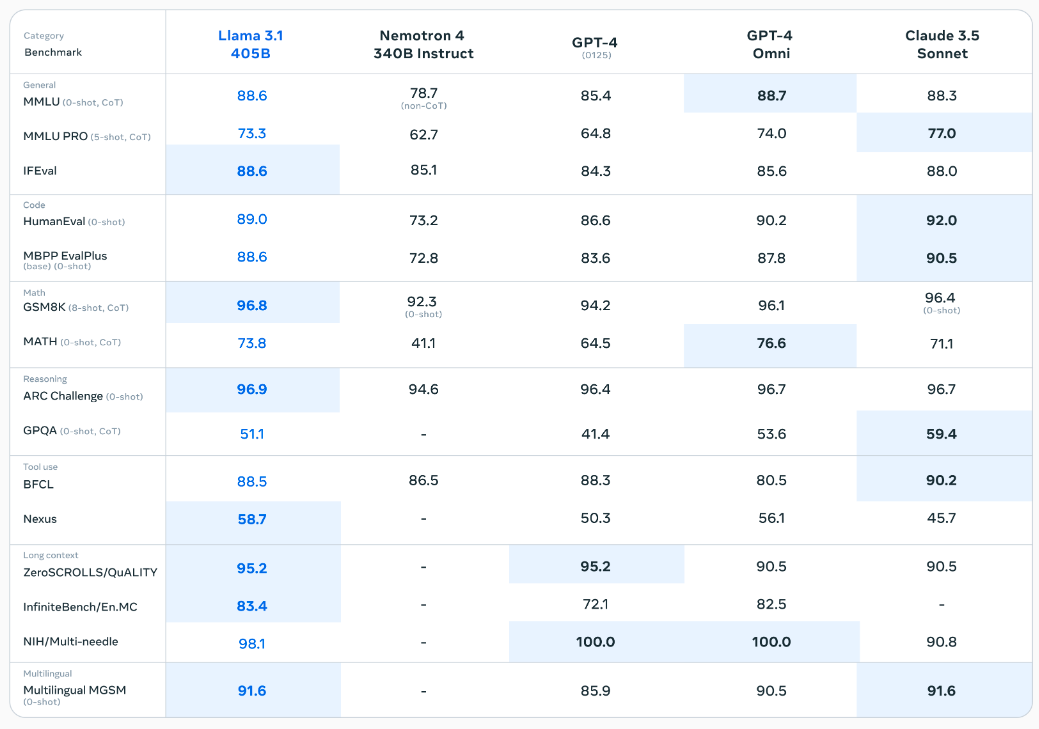

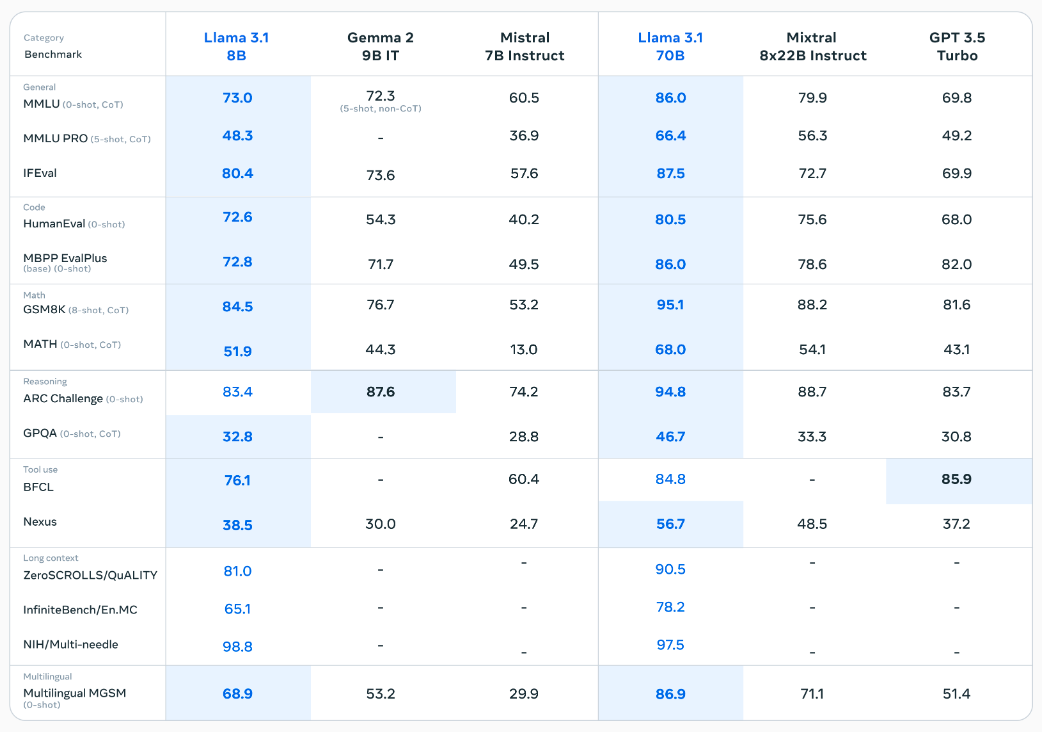

새로운 405B 모델의 가장 큰 강점은 오픈 소스 모델 중 가장 강력한 성능을 갖췄다는 점이다.

벤치마크 자료에 따르면 라마 3.1 405B는 추론 능력 측정 벤치마크인 MMLU에서 정답률 88.6%를 기록, 오픈AI GPT-4o의 88.7%와 대등한 성능을 기록했다.

이는 앤트로픽의 클로드 3.5 소네트의 88.3%를 앞지른 것이다. 경량 모델인 라마 3.1 8B 모델 역시 동급 오픈 소스 모델인 구글의 '젬마 2 9B', 미스트랄의 '미스트랄 7B' 대비 우수한 성능을 기록했다.

하지만 라마 3.1은 높은 성능에도 불구하고 몇가지 문제점이 있다.

우선 이 모델이 너무 커서 단일 GPU나 심지어 십여개의 GPU에서도 쉽게 구동할 수 없다는 점이다. 따라서 이번 라마 3.1 발표에서는 엔비디아와 협업이 힘이 됐다고 전했다.

엔비디아는 메타의 주요 파트너로 GPU를 공급하고 있다. 라마 3.1은 엔비디아 H100 GPU 1만6000개를 기반으로 훈련됐다.

하지만 메타는 라마 3.1의 사용 비용이 GPT-4o의 절반밖에 들지 않으며, 더 많은 개발자가 이를 쓸수 있도록 마이크로소프트(MS), 아마존, 구글, 엔비디아 등 20여개 기업과 협력 중이라고 밝혔다.

또 멀티모달 모델이 아니기 때문에 이미지를 이해하거나 입력할 수 없다. 대신 메타는 올해 말 멀티모달모델을 출시할 예정이라고 밝혔다.

물론, 곧 더 뛰어난 독점 모델들에 의해 성능이 추월될 가능성은 높다. 구글은 단순히 텍스트나 이미지를 생성하는 것을 넘어 복잡한 작업을 처리하는 AI 에이전트 ‘프로젝트 아스트라’를 개발 중이다.

오픈AI도 'GPT-5' 출시를 준비 중인데, 내용에 따라서는 대형언어모델(LLM)의 기준 자체를 바꿀 가능성도 있다. 앤트로픽 역시 '클로드 3.5 오퍼스'를 훈련하고 있으며, AI 에이전트도 개발 중이다.

또 메타가 라마 3.1의 사용에 대해 어떤 상업적 라이선스를 부여했는지도 정확히 알려지지 않았다. 과거에도 메타는 라마 모델의 라이선스에 둔 제한으로 인해 오픈 소스의 의미를 왜곡했다는 지적을 받았다.

이 때문에 오픈 소스 모델이라는 말 대신, '오픈 모델'이라는 용어가 점점 많이 사용되고 있다. 메타는 이번에도 훈련 데이터셋은 공개하지 않았다.

사용자들은 라마 3.1을 메타의 모바일 메신저인 왓츠앱(미국)과 메타 AI 웹사이트에서 경험할 수 있다.

마크 저커버그 메타 CEO는 "라마 3.1은 가장 진보된 모델과 경쟁할 수 있는 제품"이라며 "내년부터는 향후 출시될 라마 모델이 업계에서 가장 진보된 모델이 될 것으로 기대한다"라고 말했다.

박찬 기자 cpark@aitimes.com

- 메타, '라마 3' 중 가장 큰 모델 23일 출시..."매개변수 4050억 멀티모달모델"'

- 메타, 온디바이스 AI 언어모델 ‘모바일LLM’ 공개

- 메타, '다중 토큰 예측' 코드 생성 모델 출시..."단일 토큰보다 속도·성능 개선"

- 하루 만에 "라마 3.1 능가" 모델 등장...미스트랄, 매개변수 123B '라지 2' 출시

- 저커버그 "오픈AI라는 이름으로 폐쇄형 AI 모델을 선도한다는 것은 우스꽝스러운 일"

- 엔비디아, 기업용 미세조정 서비스 'AI 파운드리' 공개...메타와 본격 협력 체제 구축

- '라마 3.1' 훈련 54일 동안 3시간 마다 장애 발생..."GPU 문제가 대부분"

- 저커버그 "오픈 소스 정책으로 폐쇄적인 애플에 엿먹일 것"

- 메타, '맞춤형 챗봇' 플랫폼 출시..."페르소나 챗봇으로 사람 대신 인스타 활동"

- "오픈AI, 앤트로픽에 LLM 성능 밀려...오픈 소스 약진도 주목"

- 메타 "라마 4 훈련에는 라마 3.1보다 GPU 10배 더 투입"

- '라마 3.1', 출시 한달 간 다운로드 '라마 3' 62%에 불과..."이제는 수익이 문제"

- 오픈AI-메타 사용자수로 충돌..."챗GPT 주간 2억명 vs 라마 월 4억명"